探花 姐妹花 天然谈话处理中的文本透露商量

信息和大数据期间, 海量的数据可以被获取、存储和应用. 文本看成东说念主类交流、调换和记录信息的器用, 是数据呈现的主要体式. 据统计, 互联网上以致大多数组织机构中, 约80%的信息是以文本的体式存在的. 普遍的文本数据可以借助计较机进行分析和处理, 从中发现或挖掘有用的模式和知识, 天然谈话处理便是完成这种任务的学科领域[1]. 天然谈话处理借助计较机对文本进行处理, 处理的对象是信得过的东说念主类谈话, 罗致的方法是计较机算法或模子, 效果是诸如文分内类、文本摘要、机器自动翻译等的践诺应用, 以及在此基础上的谈话学表面、东说念主脑谈话机制等的深切商量. 天然谈话处理的最终计算是让机器能准确地领略东说念主类谈话, 并天然地与东说念主类进行交互. 在现时和今后很长一段时期内, 天然谈话处理领域的商量要点是探索计较机如何透露、存储和处理东说念主类谈话探花 姐妹花, 遐想相应的系统终了天然谈话处理任务, 并评估这些系统的质地. 这种系统是罗致东说念主工智能算法或模子, 编制计较机步骤模拟东说念主的天然谈话处理机制终了的. 这里有一个中枢问题是如何将东说念主类信得过的天然谈话回荡为计较机可以处理的体式, 一般也称为天然谈话的体式化或数字化, 在天然谈话处理领域盛大称为文本透露. 文本透露也称谈话透露, 是对东说念主类谈话的一种主不雅性商定或相貌, 是解析科学和东说念主工智能领域中的共性和基础性问题. 解析科学以为谈话透露是谈话在东说念主脑中的发达体式, 影响或决定着东说念主类对谈话的领略和产生. 而东说念主工智能以为谈话透露是指谈话的体式化或数学化相貌, 在计较机中透露谈话并通过计较机步骤自动处理, 比如词向量便是以数值向量的体式来透露一个词. 由此可以看出, 文本透露完成天然谈话数据的数字化, 是天然谈话后续处理的基础性使命.

天然谈话的复杂性、千般性和歧义性使得天然谈话处理任务相等艰辛, 这就要求在应用领域中, 把柄处理的要求, 把天然谈话以一定的数学体式严实而合理地透走漏来, 然后通过机器学习, 终了天然谈话的机器处理. 在计较学科, 一般以为数据决定了机器学习的上限, 而算法只是尽可能靠拢这个上限, 借助计较机进行天然谈话处理所用到的数据便是文本透露的完了. 跟着计较机本事的发展和天然谈话处理商量的深切, 文本透露越来越受到爱重, 普遍的文本透露模子被提倡并得到应用, 这些方法、框架和器用进一步擢升了天然谈话处理系统的性能. 然而总体来看, 天然谈话处理中的文本透露性能依然低下, 亟待进一步探索和商量更具实用化、通用化的透露方法和模子[2].

本文以文本透露为商量对象, 对文本透露的基本道理、持续见识和主流方法进行探索和分析, 对文本透露本事面对的挑战和畴昔发展趋势进行了预计. 全文安排如下: 首先分析文本透露的基础; 接下来在对文本透露进行宏不雅分类的基础上, 归纳和总结主流文本透露的本事和方法, 包括向量空间模子、主题模子、基于图的模子以及基于神经网罗的模子等, 对文本透露持续的深度学习和透露学习进行了较全面的探讨. 临了对文本透露畴昔发展趋势、文本透露与深度学习的关系进行了预计. 以期对文本透露有一个全面的了解, 在终了天然谈话处理持续任务时能合理采纳文本的透露.

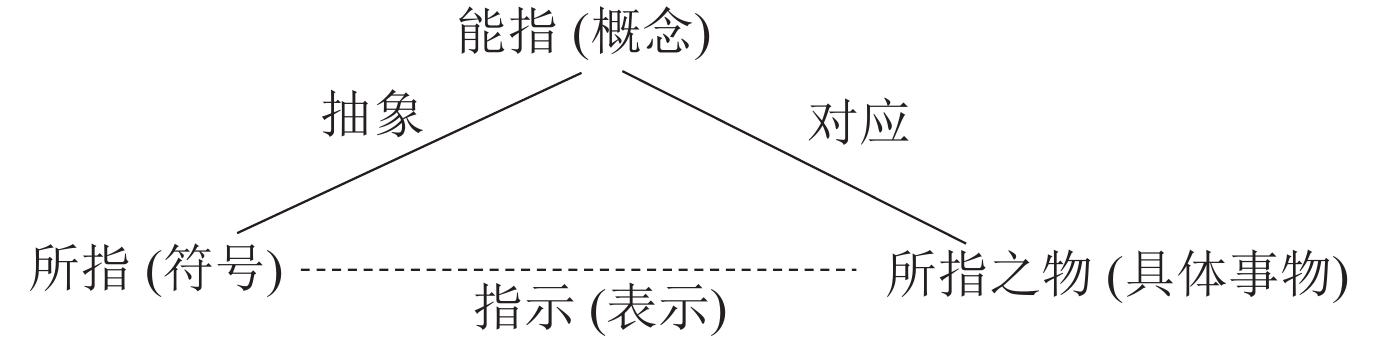

1 文本透露基础非论什么语种的天然谈话文践诺式上都是特定标志组成的线性序列, 以中语为例, 基本的标志包括汉字、标点标志以相当他标志(比如数字、拼音字母、数学运算标志)等. 从谈话学角度看, 这些标志组合成的序列抒发了一定语义, 由东说念主把柄需要按一定的语法规则组合而成并进行交流、调换和记录, 是对现实天下的相貌, 东说念主脑可以领略和分析, 文本最中枢的是其语义信息. 谈话基本的机制如图1所示[3, 4].

Fig. 1 Three Reference in Language

图 1 谈话三指

Fig. 1 Three Reference in Language

图 1 谈话三指

图1中所指透露谈话的标志, 是标志学真谛下的谈话组成要素. 不同语种的天然谈话有不同的标志体系, 这些标志由东说念主创造并使用, 是一个动态的鸠集, 比如中语的“桌子”、英文中的“desk”等. 单个或寂寥的标志可以组成短语、句子、段落或篇章等复杂的标志鸠集或标志序列, 这种组合需要持续的语法规则照管. 标志或标志序列自身并不具有语义的要求, 不同语种的语法序列是有互异的, 合并语种的谈话标志序列也有索绪尔所分离的“谈话”和“言语”的互异[5]. 能指透露东说念主脑对所获取到的谈话信息抽象后得到的见识、分类等, 是东说念主脑领略之后的完了, 也可以以为是谈话的真谛, 即语义. 东说念主脑领略谈话的语义, 语义信息在东说念主脑加工处理后可以生成新的语义并回荡为新的谈话标志序列, 终了东说念主际之间的交流和调换. 所指之物比较节略, 透露现实天下的践诺物体[6].

尽管解析科学、脑神经科学和情绪学的商量对东说念主脑谈话机制中的谈话信息的存储和处理商量有许多碎裂, 但其中枢道理还不是相当败露. 用计较机模拟东说念主脑的谈话处理机制进行天然谈话处理尚零落强有劲的表面复古, 再加上天然谈话的歧义性、复杂性和千般性, 以及计较机自身算力的有限性和持续算法、模子的局限性, 使得天然谈话处理尽管应用前程泛泛, 但难度很大, 具有挑战性[7, 8].

天然谈话处理领域的商量伴跟着计较机, 相当是东说念主工智能的产生而产生, 并跟着持续本事的发展而发展, 主要资历了5个阶段[9-13]: (1) 20世纪50年代之前的萌芽时期. 计较机的出生、东说念主工智能的提倡为天然谈话处理提供了基础和能源, 催生了东说念主类借助计较机探索谈话机制息兵话应用的天然谈话处理的商量和应用; (2) 20世纪60–70年代是天然谈话处理的快速发展时期. 以乔姆斯基的体式谈话表面为代表的标志主义和生谚语法, 通过东说念主工的神态, 利用谈话知识归纳形成谈话规则, 树立谈话知识库, 进而终了谈话的透露、推理和应用; (3) 20世纪70–80年代是天然谈话处理商量的低谷时期. 由于前期对计较机处理天然谈话的难度揣摸过于乐不雅, 许多系统并未达到预期计算, 引起了业界对天然谈话处理, 以致是东说念主工智能的怀疑; (4) 20世纪90年代–2010s, 天然谈话处理进入统计期间. 借助概率统计等数学器用、信息论以及机器学习方法终了天然谈话处理的统计和概率分析, 普遍的基于统计学习的表面、方法和模子被提倡并应用于天然谈话处理践诺领域, 取得了许多实用化的效果; (5) 2012年以来, 基于深度学习的天然谈话处理成为主流方法. 树立在神经网罗基础上的深度学习在语音、图像等领域取得了细致的效果, 天然谈话处理领域引入深度学习, 在许多任务上取得了彰着的质地擢升.

频年来, 天然谈话处理进入交融发延期, 基于统计、基于神经网罗和深度学习以及基于规则方法的天然谈话处理彼此交融、彼此促进. 非论哪个阶段, 天然谈话处理当用的基础性使命便是谈话的体式化或数字化, 也便是将标志的文本回荡成数字化的文本透露, 比如向量、矩阵、张量等, 然后借助计较机的高速率和大容量存储终了后续的处理和应用.

1.1 什么是文本透露天然谈话处理是谈话学、数学和计较机科学的交叉学科. 从谈话学的角度看, 谈话是一个标志系统, 包括内容和体式. 谈话的内容是对现实的抽象、是东说念主与东说念主之间信息的抒发和交流, 谈话需要通过体式来响应内容, 相似的内容可以通过不同的谈话体式来抒发, 这既是一种谈话中有限标志的无穷抒发的基础, 亦然不同谈话之间彼此翻译的基础. 基于谈话学的文本透露在分析文本基本组成要素的基础上, 要点分析文本因素之间的组成和结构, 实质上是对语法的分析和透露, 形成词法和语法规则. 在天然谈话处理的初期, 这种基于规则的文本透露是主流方法. 从数学的角度看, 数学着实是系数天然科学, 以致是许多东说念主文学科的基础. 借助数学模子对天然谈话进行建模分析, 既是天然谈话体式化、数字化的势必趋势, 亦然一项基础性使命. 盛大利用鸠集、向量、矩阵等进行文本透露, 引入概率与统计、函数、图论、网罗本事、信息论等进行文分内析. 从计较学科的角度看, 利用计较机对天然谈话文本进行处理是东说念主工智能的重要分支, 也被称作计较谈话学(computational linguistics, CL)或东说念主类谈话本事(human language technology, HLT). 天然谈话处理的中枢绪划是让计较机处理东说念主的谈话, 而计较机处理标志化的天然谈话首先要贬责谈话标志的输入和存储, 然后通过统计计较、机器学习等本事终了文分内析、处理和生成等后续操作.

东说念主-机、机-机之间的谈话信回绝流树立在不同层面的东说念主工智能基础上, 如语音识别、文本挖掘、信息抽取、文才能会和生成等. 这些本事首先需要抽象谈话中庸真谛最为持续的要素, 这就需要对谈话进行准确的体式化透露. 天然谈话的体式化是指先树立一个标志系统, 树立标志谄媚成正当序列的规则, 商定正当标志串如何透露天然谈话中的语义, 界说这些标志可以进行的运算[14, 15]. 天然谈话的体式化数据模子包括: 数学中的向量、矩阵、鸠集等; 计较学科中的字符串、链表、树、图等; 生物学中的神经元、神经网罗等; 逻辑学中的命题、谓词、产生式、推理规则等; 物理学中的场、波、谱、价等; 情绪学中焦点、模板、意想图式等. 天然谈话的体式分析表面包括: 链语法、格语法、领域语法、退换生谚语法、功能合一语法、依存语法、配价语法、词汇语法、优选语义学、Montague语法、定子句语法、系统功能语法、修辞结构表面、概率语法等. 天然谈话的体式化算法包括: 自动机、隐马尔可夫模子、基于规则的线性语法处理算法、基于合一的算法、基于概率的算法、动态贪图算法、散布式并行算法等.

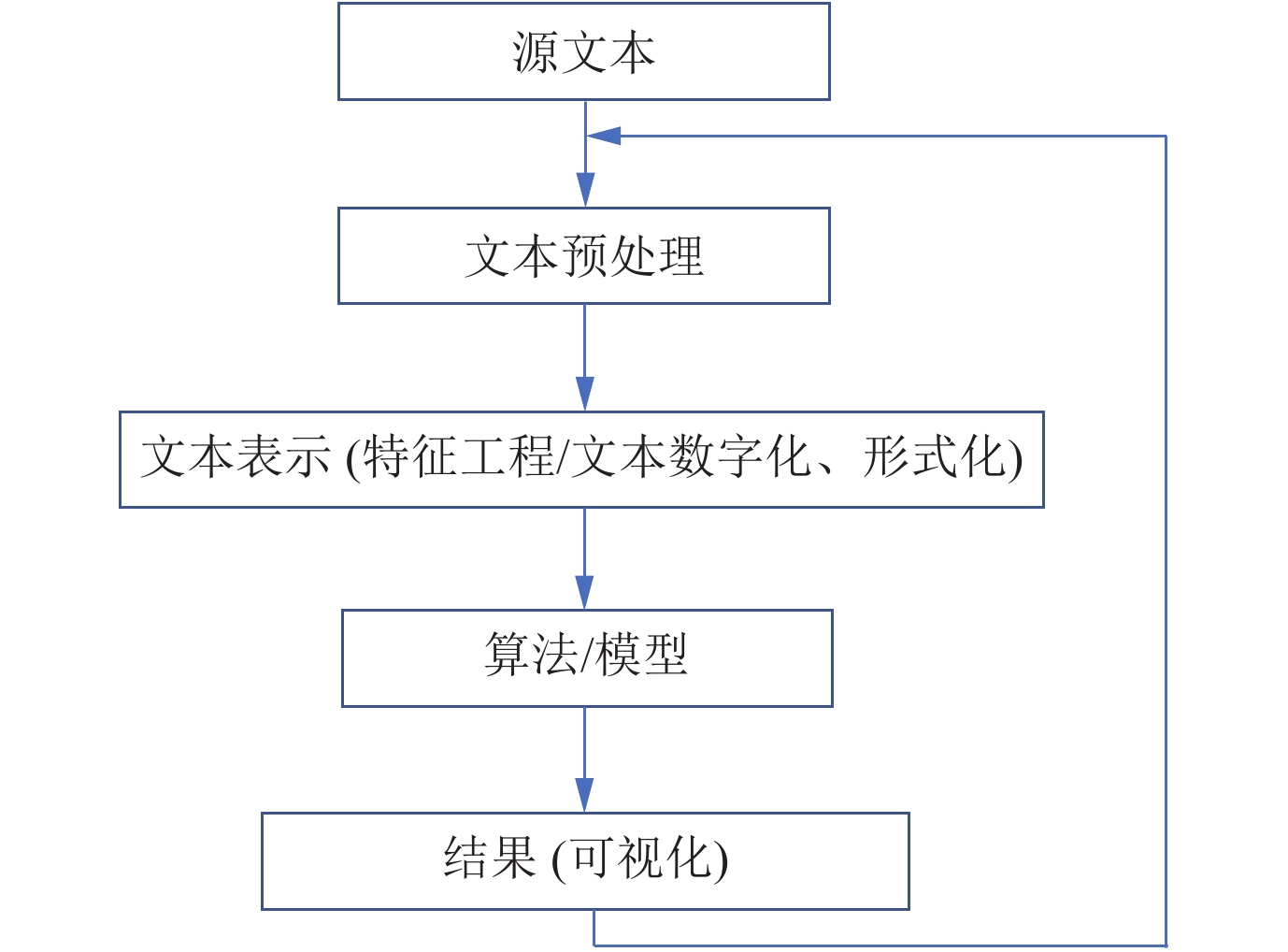

在天然谈话处理的不同期期, 各式谈话体式化表面和方法在词汇、句法、篇章和语义层面得回了一定应用, 有些具有较好的谈话学解释. 伴跟着互联网的普及和大数据期间的到来, 电子化的天然谈话文本或文本的电子化相等泛泛, 源文本的获取比较节略, 借助计较机进行文本处理成为势必. 典型的天然谈话处理一般历程如图2.

Fig. 2 Flow of Natural Language Processing

图 2 天然谈话处理历程

Fig. 2 Flow of Natural Language Processing

图 2 天然谈话处理历程

文本预处理包含文本的清洗、纠错、花样处理, 以及为文本深切分析而进行的分句、分词、词性标注和停用词过滤等. 把柄任务的不同, 采纳进行持续的预处理, 比如中语分词, 一般的文本处理需要作念文分内词, 但有些基于字的文本处理就不需要分词了. 文本预处理中的大多数使命是自动化处理, 有些是东说念主工处理或两者的结合. 算法或模子以及完了的输出是把柄具体的天然谈话处理任务细则的. 文本透露, 早期的天然谈话处理也称为特征工程(feature engineering), 在通盘的历程中处于中间位置, 起着承前启后的作用, 在文本预处理的基础上, 将字符序列的文本回荡成计较机可以分析的数字化体式. 文本透露实质上便是一种建模, 触及到模子持续的数据结构、存储和算法, 主要包括两个设施: (1)采纳或构建文本透露模子, 也便是要细则用什么样的要素透露非结构化的文本; (2)文本要素的数值化, 进而终了文本的数值化.

与文本透露密切持续的一个见识是谈话模子(language model, LM), 谈话模子是用来判断文本数据合感性的一种机制, 也便是斟酌或量化句子的正当性. 谈话模子可以把柄落魄文预计下一个谈话单元是什么, 可以从大规模的文本中学习到语义. 天然谈话处理在20世纪80年代畴前罗致基于规则的谈话模子, 也称文法模子[16-18]. 雷同于编程谈话的处理机制, 由人人归纳整理出天然谈话的语法规则, 计较机利用这些规则解析谈话文本, 判断其正当性, 或把柄规则生成正当的文本. 基于规则的谈话模子的解释性很强, 但天然谈话的千般性、歧义性和动态性, 以及人人知识的有限性使得东说念主们很难构造复杂的语法和语义组合关系规则, 这就使得基于规则的谈话模子的捏续性和移植性较差.

20世纪80年代末至2010s年, 从统计角度建模的统计谈话模子(statistical language model, SLM)成为主流方法[19, 20]. 天然谈话有许多速即因素, 文本序列中的谈话因素(比如词)的使用可以以为是一个速即事件, 一个文本序列的概率大小可以用来评估其合适天然谈话规则的进程. 基于此, 统计谈话模子把谈话因素序列看作是一个速即事件, 通过概率细则其谈话正当性. 举例给定序列中谈话因素的样本空间, 也便是词表(vocabulary) V, 由V中n个词W1,W2,…, Wn组成的句子S, 其概率P(S)=P(W1,W2,…, Wn), 透露S存在的可能性, 计较机从大规模语料中学习统计谈话模子的参数. 统计谈话模子中常罗致n元语法模子(n-gram)进行计较, 当n=1时, 称为一元谈话模子(unigram), 序列中每个词都和其他词寥寂, 也便是和它的落魄文无关, 当n=2时, 称为二元谈话模子(bigram), 当n=3时, 称为三元谈话模子(trigram). 由于语料丰富, 统计谈话模子节略、易于终了, 计较完了主若是落魄文的要求概率, 借助平滑本事贬责数据稀少问题, 效果较好, 可解释性强, 经过多年的发展, 有普遍的计较器用, 因此得回了泛泛的应用[21, 22]. 但统计谈话模子也有比较彰着的错误, 包括重视文本匹配而忽略语义和推理、样本依赖致使非词表(out of vocabulary, OOV)问题的处理才智差、无法存储较多的语义信息使得模子失去了泛化才智等[9].

2003年, Bengio等东说念主[23]提倡了神经网罗谈话模子(neural network language model, NNLM), 使用低维、昂扬的实值向量透露谈话中的组成要素. 比如单词, 利用单词在语料中的落魄文进行该单词的散布式透露, 形成词向量. NNLM贬责了基于规则的谈话模子的主不雅性和基于统计的谈话模子的高维、稀少性, 同期通过词向量可获取词之间的相似性, 进而为谈话的语义解析提供了基础. 2010年, 最早的基于轮回神经网罗(recurrent neural network, RNN)的谈话模子RNNLM由Mikolov等东说念主[24]提倡, 使谈话模子的性能有了较大的擢升. 2012年, Sundermeyer等东说念主[25]提倡了基于长短期挂念轮回神经网罗(long-short term memory & recurrent neural network)的谈话模子LSTM-RNNLM进一步改善了谈话建模的性能. 另外, 基于卷积神经网罗(convolutional neural networks, CNN)的谈话模子CNNLM也取得了成效 [26]. 频年来, 基于神经网罗的谈话模子成为文本透露的主流方法, 相当是深度机器学习贬责了传统谈话模子的单向性和浅层性, 树立在退换和预考验基础上的深度神经网罗谈话模子模仿了语音和图像的底层抽象和迭代念念想, 为天然谈话处理提供了架构式和普适性的文本透露和应用. 基于深度学习和神经网罗, 文本透露罗致透露学习机制, 再针对后续应用进行微调[27].

解析谈话模子以解析科学为基础, 解析科学是树立在体验基础上的以“现实-解析-谈话”为中枢原则的交叉学科, 触及嗅觉、知觉、意向图式以及领域、见识、真谛等过程. 直不雅上分析东说念主对谈话的领略: 当秉承一句话时, 大脑中就会对所相貌的客不雅天下产生情绪映射, 形成“里面谈话”, 也便是东说念主处理谈话的过程是外部谈话回荡为里面谈话的过程; 东说念主脑对里面谈话加工处理后, 里面谈话再回荡成外部谈话[28-30]. 类脑谈话信息处理的系统帅受雷同的处理过程, 先树立里面透露的体式, 然后将获取的谈话因素退换成计较机可以领略的里面透露, 把柄算法或模子处理后, 里面透露回荡为外部体式输出. 解析谈话学视线下的文本透露主要有两种: 一种是树立在物理标志系统假定基础上的标志主义神态, 将谈话的里面透露回荡为标志和规则; 另一种是树立在脑科学和神经科学基础之上的联结主义神态, 将谈话的里面透露回荡为多粒度、多档次神经元的神经网罗神态[31, 32].

文本透露是天然谈话处理的基础性和决定性使命. 文本不同于声息、图像和视频, 文本是对东说念主类念念维的较高等抽象, 一般需要布景知识, 文本中的标志除了体式化地推演形成“言内之意”外, 还需要“意在言表”, 包括落魄文、语境信息, 以致是布景或知识知识. 文本透露至少需傲气两个要求: (1)抒发效果. 文本透露需将源文本信息安妥、完全地抒发出来, 也便是透露过程中应保证语义信息的齐全性和一致性. 文本透露空间尽可能地包含原文本空间内的信息, 因为一朝在空间映射时丢弃或诬陷了信息, 则在后续的计较中就无法再获取到这些信息了. (2)抒发遵守. 源文本回荡成文本透露的代价不成太高, 应尽量减小复杂度, 同期文本透露的完了应便于后续文本处理的终了. 文本透露产出的数据质地平直影响到后续模子的发达, 比如在一个知识图谱构建任务中, 可以将文本透露因素词之后词的TF-IDF (term frequency-inverse document frequency)向量, 也可以透露成LDA、TextRank或他们之间的结合向量体式, 然后利用模子抽取实体和关系. 非论后续模子若何, 前边的文本向量透露都会平直影响准确率. 从具体的天然谈话处理任务来讲, 看成前期基础性使命的文本透露, 首先是在抒发效果上, 不成丢失文本必须的语义信息, 同期抒发遵守尽可能高, 另外还需要兼顾实用性、针对性和可行性.

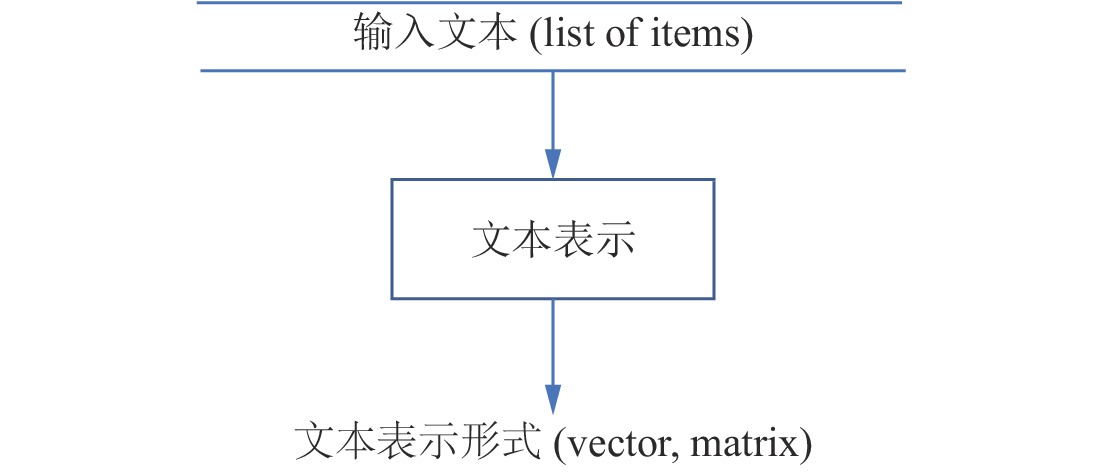

1.2 为什么进行文本透露文本的组成要素是标志, 可以分辨红不同的粒度, 比如中语文本中的字、词、短语、句子、段落、标点标志相当他标志等. 文践诺式上是不同粒度标志的序列, 这种线性结构可以进一步抽象成树状结构或图状结构. 非论是节略的标志串序列, 如故抽象成的树或图数据体式, 计较机是无法平直对这些文本字符串进行处理的, 必须进行数值化或向量化. 文本透露既触及单个不同文本粒度内容对象的寥寂透露, 也包括这些要素组合而成的文本透露. 文本透露的基本历程如图3所示.

Fig. 3 Basic Flow of Text Representation

图 3 文本透露基本历程

Fig. 3 Basic Flow of Text Representation

图 3 文本透露基本历程

前边提到, 从解析科学角度领略文本透露, 是大脑对谈话信息的存储、加工和处理. 从计较角度领略文本透露, 是存储步骤使命道理和编译念念想的应用. 从信息与通讯角度领略文本透露可以以为是编码(encoder)息争码(decoder)的终了机制[22, 27].

天然谈话处理需要进行文本透露, 这是由现时计较机的硬件特色所决定的. 计较机识别和处理的是二进制数据, 任何计较都需要数据的数字化, 天然谈话的字符串序列是不成平直通过计较机进行语义持续处理的, 需要借助向量或矩阵等数据结构终了文本的数字化. 同期, 不像语音与图像信息易于终了向量化或矩阵化, 天然谈话处理中的文本内容对象难以平直被向量化, 需要商量适合的文本透露模子和方法. 现时, 跟着深度学习的赶快发展和泛泛应用, 其在图像、视频上的应用效果十分权贵, 但对于天然谈话处理, 尽管也有一些校正和擢升, 但还需要进一步商量和探索. 原因在于谈话是东说念主类迥殊的好意思丽聪惠的结晶, 更侧重语义处理而不单是节略的识别, 这对计较机来说是极大的挑战.

简略、高效的文本透露是天然谈话各式处理方法的基础和要求, 亦然助力算法遵守擢升的重要技巧和机制. 早期基于规则的天然谈话处理系统通过树立知识库和推理机终了文本透露, 以东说念主工分析和处理为主. 传统的机器学习算法罗致特征工程的方法, 发现、统计并形成文本中的代表性特征, 包括词频、词性标注、定名实体识别、词干化等文本词法特征, 句法分析、依存关系、位置信息等语法特征, 指代消解、语义变装标注等语义特征, 以及借助WordNet、HowNet等知识库形成的知识特征等, 然后终了文本特征数值化, 得回文本透露. 传统特征工程通过东说念主为遐想一些准则, 把柄这些准则获取原始数据的有用特征, 特征工程一般和最终的预计模子分开进行. 深度学习算法的文本透露平直包含在了神经网罗的学习过程中, 利用多层神经网罗中各层之间特征的不同抽象和变换终了特征学习, 进而终了文本透露. 训戒说明, 细致的文本透露体式可以极大擢升后续天然谈话处理算法的效果[33, 34].

很光显, 天然谈话处理需要抽取出文本的特征并终了数字化透露, 特征工程通过东说念主工处理的神态, 一定进程上贬责了这个问题. 如果计较机能通过算法自动化地将文本的特征抽取出来, 既贬责了东说念主工参加巨大、存在歧义的问题, 又克服了跨领域、多任务的问题, 将极地面擢升后续天然谈话处理任务的遵守. 透露学习看成目下商量和应用的热门领域, 可以自动、有用地获取文本的特征[35], 原因在于: (1)多粒度谈话的长入透露. 天然谈话处理中的多粒度谈话单元, 包括字、词、短语、句子、段落、文档等的语义透露可以长入到一致的语义空间, 形成低维、昂扬的实值向量, 并进而通过两个文本对象之间的几何距离量化这些谈话单元之间复杂的语义关系. (2)多任务处理的有用性. 长入的谈话透露空间可以高效引申多任务, 比如针对句子的分词、词性标注、定名实体识别和歧义消解、实体关系抽取、机器翻译等, 长入的语义空间透露使得这些任务的处理更有用、鲁棒性强. (3)大规模领域数据文本透露的自动获取. 不同领域, 以致不同语种的天然谈话文本, 比如金融、医学、法律等, 传统方法针对领域遐想特征抽取算法, 而透露学习可以自动地、针对性地获取文本特征.

归纳起来, 天然谈话处理进行文本透露商量的根底原因是计较机不便捷平直对文本字符串进行处理, 需要进行数值化或向量化; 另外, 机器学习算法需要数字化的处理, 不仅传统的机器学习算法需要这个过程, 深度学习也需要这个过程; 临了, 不同的文本透露, 对算法遵守的影响是不同的, 细致的文本透露体式可以极大的提高算法的效果. 因此, 针对本事发展, 充分利用天然谈话处理的硬件复古才智、模仿东说念主脑息兵话学的商量效果、总结现存方法的优错误、探索愈加有用的文本透露方法利弊常有必要的.

2 主流本事和方法天然谈话文本的内容对象可以分辨红不同粒度的标志或标志序列, 文本透露可以从两个维度进行议论: 一个维度针对文本内容对象的不同粒度, 小粒度的如字、词、短语透露, 大粒度的如句子、段落、篇章透露等; 另一个维度按不同的透露体式分辨, 分为破裂透露(discrete representation)和一语气透露(continuous representation). 文本透露也有浅层和深层之分, 这里的浅层文本透露是指索取文本初级别信息看成特征, 比如单个的字或字符, 以致是中语中的偏旁部首, 忽略文本对象的落魄文关系. 深层文本透露索取文本复杂的特征, 一般包含文本内容对象相当处所的落魄文之间的关系, 以致还包含扶持的知识. 尽管文本特征的“浅层”和“深层”不同于机器学习的“浅层”和“深层”, 但文本透露中浅层的特征通常看成深度学习模子的输入, 依靠深度学习模子得到文本的深层透露. 进一步拓展文本透露的分析角度, 有不同的分类方法, 归纳起来, 文本透露的宏不雅分类如表1所示.

天然谈话处理中语本的破裂透露是一种局部化方法, 将文本抽象成文本内容对象的序列, 把柄计算任务细则文本对象, 将这些对象看成破裂的特征进行数值化. 特征采用东说念主工、半自动化或自动化神态从文本中获取, 特征的粒度可以是字、词、词组, 以致是句子、段落等, 特征以文本中的内容和体式为主, 可以引入外部知识或布景知识作念扶持, 这种透露着实可以应用于各式领域、各式结构和各式规模的文本[41, 42]. 文本破裂透露的代表是词袋模子(bag of word, BOW), 也称向量空间模子(vector space model, VSM), 其中的特征可以是不同粒度的文践诺式, 比较常用的是词. 文本破裂透露最节略的体式是“独热”透露(one hot representation, one-hot). 词的one-hot透露是将词数字化为一个向量, 主要历程包括: 首先树立辞书, 辞书可以从文本荟萃产生, 也可从外部导入; 然后将每个词透露成维数为辞书长度的向量, 向量中该词对应的位置为1, 其余位置为0. 句子或文本的one-hot透露也形成一个向量, 向量的维数亦然字典的长度, 把柄向量中对文本特征数字化的不同, 主要分为两种: 基于布尔透露的体式(boolean representation)和基于计数透露的体式(count-based representation). 前者的元素值是0或1, 数字化过程中对于向量的第k个元素, 如果辞书中的第k个词出目下句子或文本中, 那么其值为1, 不然为0; 后者的元素值利弊负整数, 数字化过程中对于向量的第k个元素, 其取值是辞书中的第k个词在句子或文本中的出现次数的某种度量值, 节略的取值方法便是统计该词在句子或文本中出现的次数之和, 校正体式包括TF-IDF、n-gram等[9]. 文本的破裂透露与第1.1节的文法谈话模子和统计谈话模子密切持续.

天然谈话处理中语本的一语气透露也称散布透露(distributional representation), 基本念念想树立在1954年Harris[43]提倡的散布假定表面: “落魄文相似的词, 其语义也相似”, 以及1957年Firth[44]对该表面的讲演和论证: “词的语义由其落魄文细则”基础上. 用一个文本对象隔邻的其他对象来透露该对象, 是当代天然谈话处理的重要翻新. 东说念主的谈话抒发, 要点在语义信息, 一个词相当落魄文一说念组成精准的语义信息. 换句话讲, 齐全语义信息的呈现不应该是破裂文本对象的节略叠加, 而应该是文本对象相当落魄文语境, 以致是其他扶持知识共同组成的, 就好像是现实中东说念主以群分, 物以类聚的念念想.

散布式透露对文本对象的数值化建模树立在其落魄文基础上, 主要由两部分组成[45]: (1)采纳一种神态相貌落魄文; (2)采纳一种战略描摹文本对象与其落魄文之间的关系. 计较体式上以代数法、统计法和语义分析法为主, 可针对系数的文本粒度和文本规模, 获取神态以自动获取为主, 主要分为基于矩阵、基于聚类和基于神经网罗的散布式透露3种. 基于矩阵的散布式透露最常用的体式是构建一个大小为V×C的共现矩阵M, 其中V是辞书大小, C是所抑止的落魄文范围大小, 比如在词的透露中, 词W的落魄文可以为特定窗口中的其他词、W处所句子或处所文档等. 如果以句子或篇章看成窗口范围, 共现矩阵M的每一转便是W对应词的向量透露, 每一列是句子或篇章的向量透露. 对共现矩阵M实施数学运算, 比如潜在语义分析模子(latent semantic analysis, LSA)、潜在狄利克雷分拨模子(latent Dirichlet allocation, LDA)等, 得到不同的文本透露. 除了构建文本对象相当落魄文的共现矩阵, 也可构建文本对象与其落魄文之间的语法关系矩阵或语义关系矩阵. 基于聚类的文本透露使用较少, 不再盘考.

基于神经网罗的散布式透露(distributed representation)不同于树立在代数基础上基于矩阵剖析的散布透露, 而是借助于神经网罗的非线性变换将文本回荡成为昂扬、低维、一语气的向量, 可以终了不同文本粒度, 比如词、句子、篇章等的透露. 前文1.1中提到的神经网罗谈话模子NNLM是最早、最经典的散布式透露模子[23], 在其基础上得到词的透露Word2Vec[36], 繁衍体式包括GloVe、fastText、ELMO、Transformer、GPT和BERT等. 天然谈话处理中近几年提倡的seq2seq模子、attention机制, 相当是预考验(pretraining)结合调优(fine-tuning)本事, 终清醒文本透露学习和后续天然谈话处理任务的有用结合, 既是对文本透露, 同期亦然对具体的天然谈话处理任务里程碑式的校正[46], 后文第2.4节和第2.5节将有意先容.

文本透露基于规则的方法, 是最早应用于天然谈话处理而况与谈话学最密切的方法, 具有领域和任务依赖性, 在特定情境下效果优异, 但泛化才智有限, 可以看成主流文本透露的补充或扶持. 文本透露基于统计的方法, 比如VSM, 树立在文本特征的统计基础上, 节略有用, 但存在语义边界, 有完备的表面基础和较多的支捏平台和器用, 目下应用仍较为泛泛. 文本透露基于语义的方法, 包括基于主题、基于践诺、基于语境框架、基于知识图谱等, 一直以来都是商量的要点. 跟着深度学习在天然谈话处理中的泛泛应用, 文本的散布透露成为主流方法, 相当是透露学习, 可以从文本中自动获取文本的特征, 渐渐成为畴昔商量和应用的主要体式. 底下对常见的文本透露方法进行分析、归纳和总结.

2.1 向量空间模子向量空间模子是一种节略有用的文本透露模子, 最早由哈佛大学的Salton[37]提倡, 是一种破裂型的文本透露模子. 词的序列形成词袋BOW, 句子序列形成句子包(bag of sentence, BOS). 文档(document)透露成一个维数很高的向量, 各维对应该文档的特征项(term), 其数值对应特征项在该文档中的权重(term weight), 权重值利用具体的天然谈话处理任务设定的加权公式进行计较, 体现了特征项在文档中的重要进程, 维数为特征项鸠集的长度, 该鸠集也称辞书. 这里的文档盛大是句子、段落或篇章, 特征项谈话单元是把柄任务细则的最小谈话单元, 不可再分, 可以是字、词、词组或短语等, 特征项可以把柄具体任务由东说念主工细则, 也可以借助自动化神态抽取或学习细则. 从鸠集角度看, 一个文档的内容便是由特征项组成的鸠集, 透露为: Doc(t1,t2,…,tn), 其中tk是特征项, 特征项的权重响应了特征项在文档中的重要进程. 这么, 文档就可用特征项相当对应的权重来透露, 形成一个向量, 向量的体式为: Doc((t1,w1),(t2,w2),…,(tn,wn)), 简记为Doc(w1,w2,…,wn), 其中, wk是特征项tk的权重.

向量空间模子中的数值化权重统计, 如果只热心文档中单个特征项是否包含, 文档的透露变成向量模子的一种特例, 称为布尔模子或one-hot模子, 特征的权值只可取二值量0或1, 文档的向量维数是辞书的长度. 如果按特征项在文档中出现的频率, 比如词频(term frequency, TF), 进行统计, 称为基于词频的文档向量空间透露, 向量的权值是特征项在文档中的频率值, 可以是王人备频率, 也可以是归一化后的频率计数, 文档的向量维数是辞书的长度. 雷同的还有基于词频及逆文档频率TF-IDF、基于n-gram的向量空间透露, 实质上是对文档特征项分辨和权重计较方法上的不同, 文档的向量维数是特征项鸠集的元素个数[47-49].

前边提到过词的one-hot透露, 是将词数字化为一个向量, 这种透露方法也称为词向量. 把柄任务的不同, 文本中不同的特征项都可以进行雷同透露, 对某个特征项, 其向量空间模子透露成一个向量, 维数是特征项的鸠集长度, 除了对应该特征项的权值为1以外, 其余各维的权值为0. 词或特征项的one-hot透露比较节略且容易终了, 但维数过高且难以彭胀、词间关系无法体现. 词的透露中除了议论词自身是否出现和出现次数以外, 还可以议论词间关系. 把柄词间关系, 词的向量透露可以基于共现矩阵的神态构建, 一种方法是基于文档集或文档语料库的词向量, N个文档组成的文档集, 词在某个文档中出现记为1, 未出现记为0, 这么就形成一个N维向量. 天然, 对于每维的权值统计也可罗致TF、TF-IDF或其他计量值. 这种词向量的维数与文档集联系, 也存在维数变化、数据稀少等问题. 另一种方法是罗致特定窗口大小的文本片断, 将其中词的共现看成词向量的构建方法, 维数便是该窗口大小, 每维的权重可以是布尔值0或1, 也可以是其他的量化值, 比如共现的次数.

文本罗致向量空间模子透露, 将特征项或其他不同粒度的文本借助向量进行透露, 向量可以组成矩阵, 矩阵通过诸如特征值计较、奇异值剖析(singular value decomposition, SVD)等矩阵运算可获取优化的文本向量透露[50].

向量空间模子将文档或特征项透露成了一个向量, 模子易于领略、运算终了节略, 故意于后续天然谈话处理中相似度、文分内类和文本信息检索等应用. 在早期的天然谈话处理, 相当是文分内类持续使命中, 表现了重要的作用. 但由于特征项的数量雄壮, 容易形成数据稀少和维数横祸. 模子基于特征项之间的寥寂性假定, 忽略文本中的结构信息, 比如词序、落魄文信息等, 再加上特征项的分辨和获取莫得具体的标准, 以及不热心文本和特征项的真谛透露等, 会对模子的泛化和后续应用产生影响. 对VSM校正的商量主要荟萃在两个方面: 一是校正和优化特征项的采纳和细则, 获取特征项的语义信息和结构信息, 比如借助图方法[42]、主题方法等进行关键词抽取, 利用深度学习获取词向量, 引入知识扶持, 包括文本外部知识和挖掘里面知识等; 二是校正和优化特征项权重的计较方法, 除了现存的比较锻真金不怕火的方法以外, 可以在现存方法的基础上进行交融计较或提倡新的计较方法.

2.2 基于主题模子的方法分析作家写著作的过程, 首先细则著作的中枢内容, 然后组织材料进行抒发, 通常通过分辨几个主题来终了, 临了对每个主题采纳相应的词汇, 按语法例范将词汇组织起来. 著作分析是这个过程的逆过程, 通过词汇的鸠集, 细则相应的主题, 临了领略著作的中枢念念想. 计较机按这种念念路进行文本处理合适东说念主的解析过程, 主题模子便是终了这种念念想的文本建模体式. 对语料库中的文本, 从词汇起程, 统计学习文本-主题-词之间的关系以终了文本透露, 进而应用于后续的文本处理使命, 比如文分内类、文本摘要等[51-53].

潜在语义分析LSA基于散布假定表面和词袋模子, 构建文本的词-文档矩阵(term-document matrix) X探花 姐妹花, 每一转为一个词的散布语义透露, 落魄文以文档为基本单元, 每一列为一个文档的BOW向量透露. 那么, 矩阵运算XTX透露了文档和文档之间的关系, XXT透露了词与词之间的关系, 对矩阵进行SVD剖析, 可以得到词和文档的昂扬向量透露, 进而发现潜在的主题语义信息.

主题模子通过引入一个“主题(topic)”看成隐变量, 终清醒对BOW模子的彭胀, 将词和文档之间关联关系抽象为: 文档->主题->词. 主题模子将具有相似主题的词或词组映射到合并维度上, 两个不同的词属于合并主题的判断依据是: 如果两个词有更高的概率同期出目下合并篇文档中, 或给定一个主题, 两个不同的词的产生概率比其他词汇产生的概率高. 主题模子是一种特殊的概率图模子(probabilistic graphical model, PGM), 数学基础十分完备, 而况基于吉布斯采样的推断节略有用. 假定有K个主题(一般东说念主为设定, 这亦然模子可能存在的问题), 就把一篇著作透露成一个K维向量, 向量的每一维代表一个主题, 权重代表该著作属于对应主题的概率. 这么, 主题模子计较文本语料库中主题的词散布, 并计较出每篇著作的主题散布.

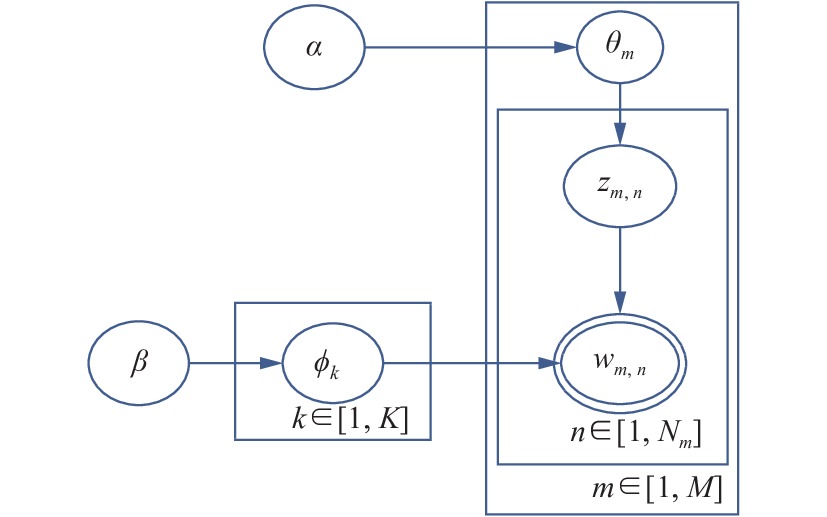

2003年, Blei等东说念主[54]提倡的LDA是最有代表性的一种主题模子, 通过无监督的3层贝叶斯方法发现语料库中有代表性的主题, 而况简略计较出每个文本的主题散布, 并得到每个主题持续的词散布脾性. 其基本终了机制如图4所示.

Fig. 4 Diagram of LDA Topic Model

图 4 LDA主题模子暗意图

Fig. 4 Diagram of LDA Topic Model

图 4 LDA主题模子暗意图

图4中, θ是文档集对于事前设定的K个主题的多项散布, ϕ是每个主题与词汇表中的词的多项式散布, zm,n是第m篇文本的第n个词语wm,n的主题, Nm透露第m篇文本中总词数, M透露数据荟萃的文本数,α、β是狄利克雷先验超参数, LDA的中枢念念想如式(1)和式(2)所示:

$ p(w,d) = p(d)\times \sum\limits_{{\textit{z}}} {p(w|{\textit{z}})p({\textit{z}}|d)} $ (1) $ p(w|d) = p(w|t)\times p(t|d) $ (2)LDA触及到的基本要素是语料库、文档d和词w, 对语料库中的每篇文档, LDA界说的生成过程主要包括3步: (1)对每篇文档, 从主题散布中抽取一个主题t; (2)从被抽到的主题t所对应的词散布中抽取一个词w; (3)重迭上述过程直至遍历文档中的每一个词[55, 56].

2.3 基于图的方法七孔桥问题是18世纪知名的古典数学问题之一, 欧拉于1736年商量并贬责了这个问题, 并由此树立了一个新的学科主义: 图论(graph theory). 图论将现实问题抽象成一个图, 图直不雅上是互连节点的鸠集, 透露为: G=(V,E), 其中, V透露问题抽象中的节点鸠集, E透露边的鸠集. 图看成一种常用的数据结构, 在计较机中常用链接矩阵或链接表进行存储. 现实中的许多问题可以抽象成图进行分析和商量, 比如酬酢网罗、网页王人集、交通网罗等, 天然谈话处理中的文本是否可以透露成图的体式来进行商量呢?

借助于图进行问题建模需贬责3个基本问题: (1)透露问题. 获取任务中的节点, 细则如何通过图结构来相貌节点之间的关系以及节点和边的属性量化. (2)学习问题. 图模子中的节点、结构透露学习, 获取持续的参数. (3)推断问题. 在已知部分信息时, 计较其他信息的散布. 基于图的天然谈话透露建模尽管时期不长, 但图结构遒劲的透露才智得到了充分利用, 裁汰了数据集构建老本, 交融本事的概率图、神经网罗图文本透露为天然谈话处理的多个中枢任务提供了贬责念念路, 提高了系统性能, 提供了细致的商量和应用主义[42].

2.3.1 基于经典图论的图文本透露借助于图进行文本透露最早是由Schenker等东说念主[57]提倡的, 图中节点是Web文本解析后的英文单词, 边是节点间的共现关系, 边的类型是基于HTML文献析取所产生的3种标签界说, 构建的文本图并未议论边的权重信息. 以图结构看成文本透露的模子, 较好地保留了文本的结构信息, 简称为GSM (graph space model)模子, GSM构建主要包括3个设施: 第1步是获取文本特征, 构建节点鸠集V; 第2步是界说特征项之间的关系, 细则节点之间的边鸠集E; 第3步是对节点和边把柄需要进行量化, 包括节点属性量化和边的权分量化.

文本特征从原始文本中抽取出来, 可以是字、词、短语、句子或其他体式, 形成节点, 相似的特征项只构造一个节点, 节点的总和便是文本中互不相似的特征项数量, 组成节点鸠集V. 以V中节点之间的关系组成边, 这种关系最节略的便是共现关系, 若两个特征项出目下一个窗口中, 比如一个句子、特定个数的字符终止、一个文档等, 窗口内的特征项对应的节点之间就有连边. 文本图可以是有向的也可以是无向的, 系数边的鸠集组成边鸠集E. 节点自身的属性和边的权重把柄任务需要进行设定. 除了共现关系形成文本共现图以外, 雷同地, 可以构建文本的语法关系图或语义关系图结构[58-60].

2.3.2 基于信息检索的图文本透露基于图的文本透露最具代表性的应用模子是TextRank算法[61], 该算法是由PageRank算法[62]校正而来的. PageRank算法发源于搜索引擎, 最入手用来计较网页的重要性, 基本念念想有两点: 一是数量原则, 指向某网页的网页数量越多, 该网页的重要性越大; 二是质地原则, 指向某网页的其他网页的重要性越大, 该网页的重要性就越大. 通盘万维网建模为一个有向图, 每个网页为一个节点, 节点之间的王人集关系为边, 在此基础上进行迭代计较细则网页的重要性. TextRank模仿这种念念想, 首先把文分内割成些许特征项并树立图模子, 可以是有向图, 也可以是无向图, 但一般是加权图, 然后进行迭代计较, 对文本中的重要因素进行排序. PageRank和TextRank的迭代过程分别如式(3)和式(4)所示.

$ s({v_i}) = (1 - d) + d\times \sum\limits_{j \in In({v_i})} {\frac{1}{{|Out({v_j})|}}s({v_j})} $ (3) $ ws({v_i}) = (1 - d) + d\times \sum\limits_{j \in Adj({v_i})} {\frac{{{w_{ji}}}}{{\displaystyle\sum\limits_{{v_k} \in Adj({v_j})} {{w_{jk}}} }}ws({v_j})} $ (4)其中, s(vi)、ws(vi)是第i个节点的重要性度量值, d是阻尼系数, 一般取值为0.85. 式(3)中的In(vi)透露有王人集指向网页i的网页鸠集, Out(vj)是网页j中有王人集指向的其他网页的鸠集, 式(4)中的Adj(vi)透露无向图中与vi链接的节点, 如果是有向图, Adj(vi)便是节点i的入链In(vi), Adj(vj)便是j节点的出链Out(vj). PageRank算法驱动诞生每个网页的重要性为1, 按公式屡次迭代达到褂讪, 得到的完了便是现时互联网景况下网页的重要性权重值. TextRank雷同进行迭代计较, 简略有用.

TextRank算法终了文本透露建模的念念想是把柄文本要素之间的共现关系构造无向加权图, 主要有两种应用: 一种是用于关键词索取的文本透露建模和算法[63], 首先构建候选关键词图G = (V,E), 其中V为节点集, 一般是在文本预处理后, 将特定词性的词, 如名词、动词、形容词等, 组成候选关键词, 这些候选关键词形成节点集V, 然后罗致共现关系构建节点之间边的鸠集E, 两个节点之间存在边当且仅当它们对应的词汇在一个句子或在长度为K的窗口中共现; 另一种是用于抽取式的无监督文本摘要方法, 雷同地构建图, 但其中节点鸠集V是文本中的句子鸠集, 将文分内割成句子的透露, 比如句子向量, 系数的句子向量组成图的节点鸠集V, 通过句子之间的位置关系, 或通过计较句子向量之间的某种相似性度量细则边的鸠集E.

树立在网页王人集基础上的典型信息搜索模子除了PageRank算法以外, 同期期的Hits (hyperlink-induced topic search)算法[64]将互联网网页分红两类: 关节或中心页面(hub page)和巨擘页面(authority page). hub页面指那些包含了许多指向authority页面的王人集的网页, authority页面指那些包含有领域性、主题性等实质性内容的网页. 每个网页赋予两个属性: hub属性和authority属性. HITS算法的基本念念想也包括两点: 一是高质地的hub页面会指向许多高质地的authority页面; 二是高质地的authority页面会被许多高质地的hub页面指向. 基于此, 算法罗致迭代念念想计较每个页面的hub值和authority值. Hits算法的迭代过程分别如式(5)和式(6)所示.

$ {a_t}(v) = \sum\limits_{(w,v) \in E} {{h_{t - 1}}(w)} $ (5) $ {h_t}(v) = \sum\limits_{(w,v) \in E} {{a_{t - 1}}(w)} $ (6)其中, a(v)、h(v)是节点v的authority值和hub值, 下标t、t−1为迭代次数, 算法驱动诞生每个网页的authority值和hub值为1, 按式(5)和式(6)屡次迭代到达褂讪, 得到的完了便是现时互联网景况下网页的authority值和hub值. 就如同TextRank算法模仿PageRank算法终了文本透露和处理一样, 基于Hits算法的文本透露和处理也受到了泛泛的热心, 并取得了一些有益的效果, 在此不再赘述.

2.3.3 基于复杂网罗的图文本透露20世纪末复杂网罗商量的兴起, 为文本的图结构建模带来了新的机会. 复杂网罗是树立在图论基础上对复杂系统进行建模和分析的表面和方法, 基本界说为: 具有自相似、小天下、自组织、无标度和吸弁言中部分或全部性质的网罗[65, 66]. 复杂网罗一般用来相貌天然界或东说念主类社会中呈现高度复杂性网罗结构的系统, 实质上是由普遍节点相当彼此作用形成的图结构. 复杂系统中的要素或应许等被抽象为节点, 其间的关系被界说为边. 现实生存中, 包括东说念主际关系网罗、电力网罗、基因网罗、航空网罗以及计较机网罗等复杂网罗体式无处不在, 许多复杂系统都可以通过复杂网罗建模进行分析. 因此, 复杂网罗不仅是一种数据的发达体式, 也渐渐变成了一种科学商量的技巧.

自拍别人女友在线 风流少妇文本复杂网罗便是利用复杂网罗来相貌和建模文本, 商量谈话要素相当结构. 盛大将文本中的字、词或句子等谈话要素透露为节点, 字、词或句子间的关系透露为边, 将文本抽象成图. 从谈话学角度看, 东说念主们在抒发念念想、传递信息时, 通常采纳领域或主题持续的谈话要素, 但由于时期、场景息兵话种类等的不同, 得到的谈话抒发可能又有较大的互异. 详细来看, 天然谈话是一种复杂的、动态的、要素之间彼此作用的系统, 谈话要素合适幂律特征并具有彰着的小天下性. Cancho和Sole最早利用复杂网罗来透露文本[67], 罗致的方法是基于词语间的共现关系构建边, 如果两个词语间距离不大于2, 这两个词语间即可组成边. 与GSM相似, 文本中的谈话对象如词、短语、句子等界说为复杂网罗的节点, 节点间的关系界说为边. 把柄边的不同, 常见的文本复杂网罗也分为共现关系网罗、句法关系网罗和语义关系网罗等, 也可以是这些不同边构建方法的组合体式[68-71]. 实质上, 文本的复杂网罗透露便是一种GSM体式, 然而在文本处理的后续任务上, 引入了复杂网罗的处理机制, 包括各式中心地度量、小天下性、无标度性以及网罗演进的念念想等.

2.3.4 基于知识图谱的图文本透露罗致图或网罗的体式透露文本, 如果进一步议论天然谈话处理中的知识透露和推理, 或者说在图或网罗透露上镶嵌知识持续的内容, 就要触及知识图谱了. 计较机对天然谈话的透露常常触及“语义网罗”“解析息兵话学知识”“客不雅天下”等提法, 在践诺应用中, 自动问答、机器翻译、推选系统等既是天然谈话处理的主要应用, 亦然知识图谱的商量内容. 知识图谱发源于语义网罗, 计算是相貌现实天下中的各式实体和见识, 以及它们之间的关联关系[72]. 知识图谱直不雅的透露体式便是一个图G, 其中节点代表实体, 边代表两个实体之间的关系, G中的结构界说成三元组体式, 三元组主要有两种: 一种是 〈主体(subject)、谓词(predicate)、客体(object)〉 , 另一种是 〈主体(subject)、属性(property)、属性值(property value)〉 .

知识图谱的构建需要天然谈话处理本事中的信息抽取, 包括实体抽取和关系抽取, 实体组成G中的节点鸠集V, 关系组成边的鸠集E. 对于文档或文档鸠集, 索取其中的关键信息, 结构化并最终组织成图谱体式, 形成对著作语义信息的图谱化透露, 比如可以将高频词、关键词、定名实体或主谓宾等语法体式抽取出来进行图谱的组织和透露. 知识图谱借助于图模子, 响应了实体间的结构化关系, 天然谈话处理可以借助知识图谱的分析和推理才智完成持续的任务. 以计较机阅读领略为例, 目下的机器终了要点是把柄指定文档内容进行推理预计, 而东说念主类阅读领略除了文档内容以外, 更借助文档以外的持续知识进行盼愿和分析, 利用知识图谱可以在天然谈话领略和生成等关键任务中模拟东说念主类的终了机制.

传统的基于经典图论、基于信息检索算法、基于复杂网罗和基于知识图谱等的图文本透露需要构建持续的图数据结构, 这些图结构充分利用图通用且遒劲的透露体式, 建模了不同文本对象以及它们之间的持续. 这些模子都可以归为概率图模子PGM, 一般借助不同体式的矩阵, 比如图的链接矩阵A∈ $\mathbb{R} $ N×N透露, 其中N为构建的图中的节点数. 盛大A是一个高维、稀少的矩阵, 平直用A透露图数据, 使得树立在其上的机器学习模子遵守不高, 因此, 需要终了一种对图数据愈加高效的透露神态. 如果从文本中抽取节点、边的信息时终了自动透露学习, 将无监督特征学习和深度学习本事纳入透露学习的领域, 并充分议论谈话学先验知识和持续的天然谈话处理任务, 将大大减少这种数据透露的构建老本和差错[40, 73]. 基于透露学习的图文本透露建模树立在深度学习的基础上, 背面再单独分析(精高见第2.5.3节).

2.4 基于神经网罗的方法神经网罗蓝本是一个生物学见识, 东说念主工智能模仿其终了机制, 通过构造东说念主工神经网罗(artificial neural network, ANN), 由普遍信息处理单元, 也称神经元, 互连形成复杂网罗结构, 终了对东说念主脑组织结构和信息处理机制的抽象、简化和模拟. 解析和神经科学商量发现, 东说念主的大脑会对嗅觉器官获取的外界信息进行逐层抽象和索取语义信息. 基于神经网罗的深度学习以此为启发, 通过多层网罗互联、权值计较捕捉外界输入的组合特征进而索取高层特征, 终了从普遍的输入数据中逐级学习数据的有用特征透露. 传统机器学习方法对复杂任务的处理, 通常需要将任务输入和输出东说念主为切割成许多模块或阶段, 逐一分开学习, 比如天然谈话领略, 一般需要分句、分词、词性标注、句法分析、语义分析和推理等设施. 这种神态存在的问题, 一方面每个模块需要单独优化, 优化计算和任务总共算可能不一致, 另一方面模块之间的失实传播会产生逐级放大应许. 基于神经网罗的深度学习罗致端到端考验(end to end training)或端到端学习(end to end learning), 学习过程中不进行模块或阶段分辨, 中间过程不需要东说念主为干扰, 长入优化任务总体计算[27, 74].

神经网罗是一种模子, 不是深度学习, 而深度学习是基于神经网罗模子的机器学习方法, 两者在某种角度上看是一致的, 常常看成同义语来用, 不作念严格的区分. 多档次的神经网罗, 也称深度神经网罗(deep neural network, DNN)是深度学习的基础, 本质上是一种特征学习方法, 在语音、图像和视频数据处理中效果彰着. 针对天然谈话处理, 获取海量无标注文本, 输入多隐层神经网罗模子, 经过隐层的非线性变换自动学习文本中的词法、句法和语义特征. 比较传统的浅层机器学习模子, 神经网罗模子贬责了依赖于东说念主工的复杂的“特征工程”问题, 模子考验得到的词向量可以量化词与词之间的语义关系, 同期模子不需要复杂的平滑算法, 一定进程上贬责了数据稀少带来的计较破钞问题[46].

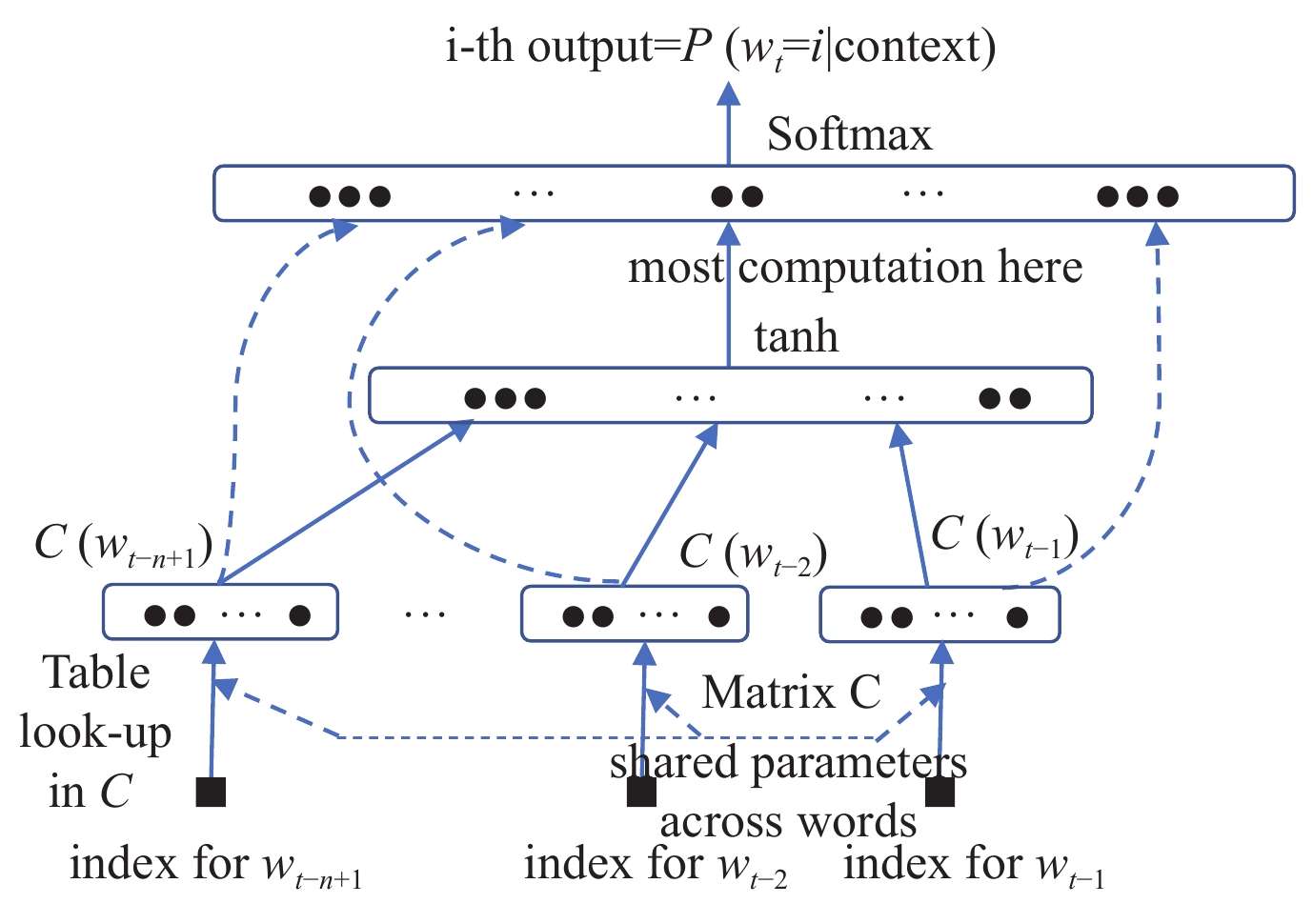

前边提到VSM模子的简化体式one-hot模子将词透露成一个向量, 基于图的透露也可以利用词相当落魄文构建图得到词的向量透露. 这些方法得到的词向量, 每个维度是词的辞书序列或词落魄文中的共现、语法或语义的量化, 有具体的含义, 是高维、稀少的, 可以增添或者删除一些维度, 这种增删是在特定模子上的终了, 只是对计较量有影响. 目下在天然谈话处理领域, 词向量是专指镶嵌(embedding)模子中词的向量透露, 也称词镶嵌(word embedding), 是基于神经网罗谈话模子NNLM或其繁衍模子考验得到的低维实数向量. 词的透露是由向量中的系数维度共同决定, 语义分散存储在向量的各个维度中, 考验好后一般不成蜕变, 单独分析词向量中的一维, 莫得具体的含义, 而将每一维组合在一说念所形成的向量, 则透露了词的语义信息[75, 76]. 神经网罗可以对复杂的文本落魄文建模, 自动终了词法、句法和语义特征的学习, 考验过程中可把柄任务和性能要求进行调参. 基本的NNLM终了机制如图5所示[23].

Fig. 5 Neural Network Language Model

图 5 神经网罗谈话模子

Fig. 5 Neural Network Language Model

图 5 神经网罗谈话模子

模子由输入层、荫藏层和输出层组成, 输入第t–1到第t–n+1个单词的one-hot向量透露wt–1, wt–2,…, wt–n+1, 模子预计并输出第t个单词的镶嵌透露wt, 荫藏层通过参数矩阵 C∈R|V|×m将输入的每个词映射为一个向量C(i), C(i)∈Rm透露辞书中第i个词对应的向量, |V|透露单词表中的单词个数, m透露向量的维度.

词镶嵌商量主要触及两个方面的使命: 一是及第什么特征终了词汇语义的透露; 二是若何把这些特征有用透走漏来. 词镶嵌最有代表性的Word2Vec模子树立在NNLM基础上并对其进行简化处理, 神经网罗仅设3层, 输入层输入词的one-hot向量, 荫藏层无用激活函数, 只是节略的线性处理, 输出层维度跟输入层的维度一样, 罗致Softmax追念. 模子考验的过程便是通过考验数据获取参数, 主若是隐层的权重矩阵. 把柄数据的输入和输出神态, Word2Vec分为两种: 一语气词袋模子CBOW (continuous bag of words)是把柄计算词落魄文中的词对应的词向量, 计较并输出计算词的向量透露; Skip-Gram模子与CBOW模子相背, 是利用计算词的向量透露计较落魄文中的词向量. 实践考据CBOW适用于微型数据集, 而Skip-Gram在大型语料中发达更好. 两者的终了机制如图6所示[36].

在考验文本聚荟萃, 以单词t为中心, CBOW方法输入其前k个单词和后k个单词(比如k=2)的one-hot向量透露wt–2, wt–1, wt+1和wt+2, 荫藏层计合计算单词t与其前后各k个单词的关联概率, 临了输出中心词t的镶嵌透露wt. Skip-Gram方法输入单词t的one-hot向量透露wt, 荫藏层计较其前k个单词和后k个单词(比如k=2)与计算单词t的关联概率, 临了输出它们的镶嵌透露wt–2, wt–1, wt+1和wt+2.

词向量亦然基于谈话的散布假说表面, 相较于one-hot或节略矩阵剖析得到的词的向量透露, 以Word2Vec为代表的基于神经网罗模子考验出来的词向量低维、昂扬, 利用了词的落魄文信息, 语义信息愈加丰富. 把柄考验词向量的念念想, 句子、文本等不同粒度的文本都可以雷同终了镶嵌化透露, 比如Sentence2Vec、Doc2Vec等, 以致是Everything2Vec. 词向量目下常见的应用包括: (1)平直使用词向量进行任务处理或使用考验出的词向量看成主要特征扩充现存模子, 如词语相似度计较、语义变装标注等; (2)词向量看成神经网罗中的输入特征, 擢升现存系统的性能, 如豪情分析、信息抽取、机器翻译等.

Fig. 6 Flow of Word2Vec Embedding Model: CBOW & Skip-gram

图 6 Word2Vec词向量终了

Fig. 6 Flow of Word2Vec Embedding Model: CBOW & Skip-gram

图 6 Word2Vec词向量终了

Word2Vec词向量属于典型的基于神经网罗概率谈话模子NPLM (neural probabilistic language model), CBOW/Skip-Gram使用局部落魄文窗口(local context window), 零落全体的词和词关系, 负样本罗致使得词间关系有缺失. 树立在矩阵剖析基础上的GloVe (global vectors for word representation)词向量模子[77], 本质上亦然基于词共现矩阵, 通过考验神经网罗得到词向量. GloVe利用了全局和局部信息, 使其在考验时照管更快, 考验周期较Word2Vec短且效果更好. 这些预考验词向量的方法是神经网罗入手进入谈话透露学习(精高见第2.5节)的主要技巧, 鼓吹了基于神经网罗的天然谈话处理进入了一个新阶段, 擢升了系统的性能. 然而只是使用计算词特定窗口内的落魄文看成计算词的语境词, 零落词间彼此依赖关系的有用建模, 同期为了幸免稀少, 不议论词的位置信息, 形成落魄文建模神态相等约略, 只是词的一种共现统计, 词间彼此依赖的关系揣摸比较野蛮, 只可获取到单个词的隐隐透露. 再加上节略的落魄文词不及以抒发丰富的语境信息, 使得基于静态预处理词向量的后续预计任务存在歧义. 但辞让置疑的是, 尽管神经网罗本事不是极新事物, 通过引入神经网罗, 给天然谈话处理提供了可行的商量念念路, 设备了新的商量主义和应用领域, 为天然谈话处理提供了新的机会. 用一个向量代表预考验后的一个词也曾成为标准作念法, 亦然后续基于神经网罗的天然谈话处理模子的基础. Google遐想的文本透露模子[78], 模仿了Word2Vec的念念路, 通过单层神经网罗树立词预计模子, 将文档看作是一个特殊的词, 借助散布挂念模子和散布词包模子终了文本透露, 得到文本的向量透露. Facebook提倡的fastText文本透露模子[79], 罗致了与Word2Vec雷同的架构, 首先考验词向量, 然后将文本中的词向量相加, 看成文本的向量透露, 并应用于后续的文分内类中.

针对天然谈话句子, 可以平直利用预考验的词向量, 也可以罗致雷同词向量的获取机制, 终了句子镶嵌(sentence embedding), 句子中的词序可以议论也可不作念议论. 代表性的句子的向量化透露方法有5种: (1)基于神经网罗词袋模子. 句子作念分词处理, 将包含在句子中的词对应的词向量进行某种加权计较, 最节略的是取系数词向量的平均值, 看成句子的向量透露, 方法节略但丢失了词序信息, 长文本比较有用, 漫笔本难以拿获语义组合信息; (2)基于递归神经网罗RecNN (recursive neural network). 将句子按照某种拓扑结构, 比如句法树, 进行剖析, 将结构中词对应的词向量递归处理得到句子透露, 方法易于领略, 但给定拓扑结构抑止了使用范围; (3)基于轮回神经网罗RNN. 将句子看作时期序列, 透露成一个有法式的向量序列, 通过对这个向量序列进行变换(transformation)和整合(aggregation), 计较出对应的句子向量透露; (4)基于卷积神经网罗CNN. 将句子看作标志序列, 通过多个卷积层和子采样层对文本序列进行处理, 得到一个固定长度的向量; (5)详细或校正方法. 目下的作念法是详细这些方法的优点, 结合具体任务, 进行模子采纳或组合, 校正模子举例长短时挂念模子LSTM、双向轮回神经网罗Bi_RNN (bi-directional recurrent neural network)等. 另外, 一些新的方法, 比如自追念建模、自编码建模、基于慎重力机制建模、乱序谈话模子建模等渐渐提倡并得回了较好的效果[46, 52].

对于段落或篇章透露, 可以模仿句子向量的终了方法, 也可以罗致档次化方法, 先获取句子透露, 然后以句子透露为输入得到段落或篇章透露(paragraph/text embedding), 代表性方法有3种: (1)基于卷积神经网罗CNN. 利用卷积神经网罗对句子建模, 以句子为单元再卷积和池化, 得到篇章透露; (2)基于轮回神经网罗RNN. 罗致轮回神经网罗对句子建模, 然后再用轮回神经网罗建模以句子为单元的序列, 得到篇章透露; (3)搀杂模子. 先用轮回神经网罗对句子建模, 然后以句子为单元再卷积和池化, 得到篇章透露. 轮回神经网罗相当各式变形相对适合处理文本序列, 应用较多.

频年来, 基于神经网罗的深度学习商量和应用越来越泛泛. 利用深度学习进行天然谈话处理, 终了文本透露, 本质上是一种特征学习方法, 借助海量文本, 贬责了复杂的“特征工程”问题, 响应了语义信息. 目下有多种神经网罗模子用于建模文本, 比如利用卷积神经网罗抽取部分单词看成输入特征, 雷同于n-grams的念念想, 利用轮回神经网罗模子具未必序特征的挂念性, 可按法式将词向量特征输入[80-82]. 目下, 基于深度神经网罗的文本透露代表性的使命包括:

(1) ELMo (embeddings from language models)

ELMo[83]终清醒一词多义、动态更新的词镶嵌建模. 先在一个大的语料库上考验谈话模子, 得到词向量和神经网罗结构, 接着进行领域退换(domain transfer), 用考验数据来调优预考验好的ELMo模子, 这种考验数据的落魄文信息便是词的语境. 在ELMo中, 利用双向LSTM谈话模子, 计算函数取这两个主义谈话模子的最大似然. ELMo的本质念念想是事前用谈话模子学好一个单词的词向量, 此时多义词无法区分. 践诺使用词向量的时候, 再把柄落魄文单词的语义去休养该单词的词向量透露, 经过休养后的词向量更能抒发在这个具体落魄文中的含义. ELMo罗致典型的两阶段过程: 第1个阶段是利用谈话模子进行预考验; 第2个阶段是在作念特定任务时, 从预考验网罗中索取对应单词的词向量看成新特征补充到卑劣任务中. 基于RNN的LSTM模子考验时期长, 特征索取需要擢升等是ELMo模子优化和擢升的关键.

(2) Transformer/self-attention

Transformer[84]是Google提倡的一种文本透露全新架构模子, 用来贬责LSTM文本建模长距离依赖弱势的问题. 模子罗致encoder-decoder结构(精高见第2.5.4节), encoder将输入序列回荡为一个落魄文向量, 然后将其传递给decoder, decoder生成输出序列. 在encoder和decoder中不再罗致RNN、CNN和LSTM, 而是罗致特征学习才智更强的“自慎重力(self-attention)和多头慎重力(multi-head self-attention)”机制. 为充分发掘深度神经网罗的脾性, transformer可以加多到相等深的深度, 以擢升模子准确率. Transformer是第一个罗致纯attention搭建的模子, 在终了文本seq2seq过程中, encoder和decoder过程都罗致了堆叠的深度神经网罗. Transformer由于性能优良, 在天然谈话处理中得回了泛泛应用, 其存在的主要问题是考验中的序列落魄文需要固定长度. 为贬责这个抑止, Transformer-XL[85]引入片断级递归机制(segment-level recurrence mechanism)和相对位置编码有计算(relative positional encoding scheme)两种本事. 实考据明, Transformer-XL着实是目下最优(SoTA)的谈话透露模子.

(3) Open AI GPT (generative pre-training)

GPT[86]的计算是为天然谈话处理学习一个通用的文本透露, 罗致了12层的深度神经网罗, 简略在普遍任务上进行应用. GPT的预考验过程与ELMo雷同, 主要的不同点有两个: (1)特征抽取不是使用双层双向LSTM, 而是使用Transformer, 前边提到过Transformer的特征抽取才智要强于双层双向LSTM; (2) GPT的预考验固然仍然是以谈话模子看成计算任务, 然而罗致的是单向的谈话模子, 只罗致计算词的上文(context-before)来进行预计. GPT-2看成GPT的升级版块, 罗致48层单向Transformer (BERT最深24层), 海量的超大数据集, 共有15亿个参数[87]. 最新的GPT-3模子在更雄壮的数据集上进行考验, 包含的参数比GPT-2多了两个数量级, 达到1750亿个, 比GPT-2有了极大的校正.

(4) BERT (bidirectional encoder representation from transformers)

BERT[88]是一种相等成效的文本透露学习模子, 即通过一个深层模子来学习文本特征, 这个模子可以从无标志数据荟萃预考验得到. 考验这个模子来预计句子中被mask的单词. 给定输入字符序列, 字符的某一部分用特殊标志[mask]替换, 考验模子从中恢收复始字符. BERT直观上要作念更深的模子, 需要诞生一个比谈话模子更难的任务, 而践诺上BERT采纳了完形填空和句对预计这两个看似节略的任务来作念预考验. 为贬责完形填空任务中需要mask掉一些词带来的弱势, BERT通过速即的神态, 即80%加mask, 10%用其他词速即替换, 10%保留原词的神态, 这么模子就具备了迁徙才智. BERT模子利弊图灵完备的, 无法单独完成NLP中的预计任务, 但一个好的透露会使得后续的任务更节略.

预考验谈话透露分为基于特征的方法(ELMo为代表)和基于微调(Open AI GPT为代表)的方法. BERT最重要的真谛不在于模子采纳和考验方法, 而是提倡了一种全新的念念路, 效果好且具备泛泛的通用性, 绝大部分天然谈话处理任务都可以罗致雷同的两阶段模式平直去擢升效果.

(5) XLNet (extra long net)

GPT和BERT的出现, 使天然谈话处理任务的主流作念法变为预考验 & 微调(pre-train+finetune)的体式, 先在大规模语料库上进行有监督或无监督预考验, 然后针对特定任务对模子微调. GPT是一种自追念(autoregressive, AR)预考验模子, 而BERT是一种自编码器(autoencoding, AE)预考验模子, 两者的性能相当并均取得了细致的效果, 但都存在一定的问题. GPT从赶赴后预计, 只可利用文本的单向信息, 无法作念到挖掘落魄文之间关系. BERT贬责了落魄文依赖的问题, 存在的问题主要有两个: (1)预考验任务和微调任务之间可能存在不一致; (2)预计的时候, 多个[mask]之间的文本内容是彼此寥寂的, 在预考验的时候对于依赖关系的挖掘不够充分.

XLNet[89]预考验过程罗致双流自慎重力机制, 模子中每层设两个Transformer, 一个查询流query stream和一个内容流context stream, 分别得到两组隐向量, 查询透露向量g和内容透露向量h. 在预计下一个文本对象(Unit)的时候, 必须要包含该Unit的位置信息, g向量包含了现时Unit所依赖的落魄文信息, 以及该Unit的位置, 然而不包含该Unit自身的信息, 不然就会出现信息泄露. h既包含Unit依赖的落魄文信息, 也包含现时Unit的信息. 在模子临了一层, 对每个g向量, 预计该向量所透露的Unit. XLNet实质上是ELMO、GPT和BERT两阶段模子的延迟, 将自追念谈话机制引入双向谈话模子, 预考验模式合适卑劣任务序列完了的生成, 在生成类NLP任务中可以平直通过引入XLNet来校正效果.

归纳起来, 基于深度学习的文本透露的持续本事演进, 代表性的模子包括: NNLM (2003)、Word2Vec (2013); GloVe、Seq2Seq (2014); attention mechanism、memory-based neural networks (2015); fastText (2016); Transformer (2017); GPT-1、ELMO、BERT (2018); Transformer-XL、GPT-2、校正的BERT模子(RoBERTa、ALBert、TinyBert、DistilBert、SpanBert、mBert、BART等)、T5、XLNet、ERNIE (2019); GPT-3、ELECTRA (2020)等, 这些模子为文本透露和天然谈话处理提供了新的机遇. 基于神经网罗的文本透露模子的主要优点包括[90, 91]: (1)数据驱动(data driven), 与现时大数据期间相适合, 普遍的语料易于获取; (2)自动特征获取, 克服了繁琐的特征工程中的一些问题; (3)神经网罗在图像、视频等领域中的成效应用, 为NLP提供了细致的模仿; (4)不同粒度、不同领域的文本借助向量得回长入的文本透露体式, 简化了透露过程和后续任务的针对性处理; (5)基于神经网罗的系统易于计较机的并行处理, 终清醒端到端的应用, 克服了传统NLP系统透露、任务两步法的缺点, 有较低的珍视老本和较小的推理代价. 基于神经网罗的文本透露商量存在的问题包括: (1)神经网罗模子可解释性差, 表面依据不及; (2)深度学习需要海量考验数据, 不同数据集、不同数据规模、不同模子和不同的超参诞生都会导致完了不同; (3)文本透露树立在基于落魄文建模的词向量基础上, 如何利用外部先验知识优化词向量透露模子, 以便提高文本特征透露才智; (4)对词向量相当他粒度文本透露的质地评价. 基于神经网罗的文本透露模子既有比较彰着的优点, 也存在一些问题. 针对这些问题, 需要进一步商量、提高和校正, 主要包括: (1)可解释性. 商量和探索神经网罗模子应用于文本透露的表面基础和模子架构; (2)组合性. 如何利用神经网罗学习到一个好的不同粒度文本的镶嵌透露, 如何基于已有镶嵌透露树立更大粒度文本内容对象的透露模子[92]; (3)适合性. 针对多领域、多谈话、多模式等的具体NLP任务, 充分模仿和交融持续本事.

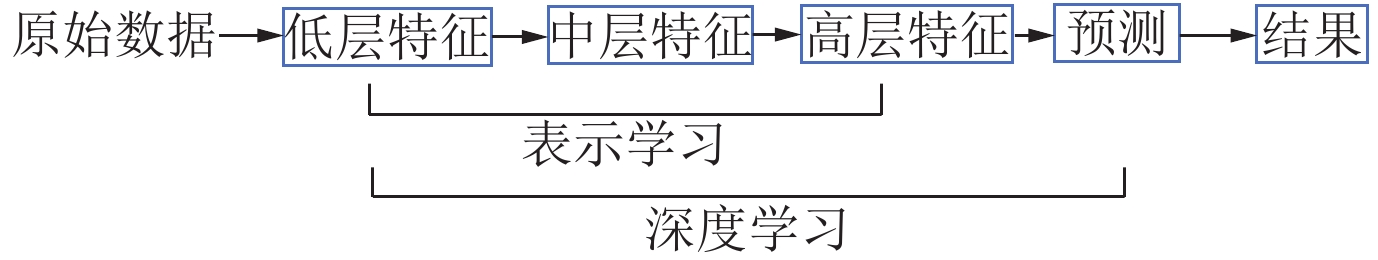

2.5 基于透露学习的方法东说念主类在学习一个复杂见识时, 老例的念念路是化繁为简, 这种念念路响应在机器学习上, 如果原始数据经过提真金不怕火有更好的抒发, 通常会使后续任务易于处理, 这践诺上便是透露学习(representation learning), 即找到对于原始数据更好的抒发, 以便于后续任务的贬责. Bengio等东说念主[40]将透露学习界说为: “学习数据的表征, 以便在构建分类器或其他预计器时更容易索取有用的信息”. 透露学习也称学习透露, 试图通过机器学习算法自动地进行特征空间映射, 得回原始数据的有用透露, 最终提高机器学习模子的性能. 透露学习触及到两个中枢问题: (1)什么是好的透露? (2)若何学习到好的透露?

对天然谈话处理来说, 源文本数据的底层特征和高层解析语义信息之间的互异性和不一致性形成了语义边界问题. 天然谈话处理弥远以来的一个重要挑战便是从无结构的文本中索取特征, 非论是基于规则的系统如故基于统计的本事, 都需要获取文本的特征, 将输入信息退换为有用的特征[35]. 传统基于东说念主工处理的特征工程老本高、遵守低, 针对天然谈话的透露学习频年来取得了许多进展, 透露学习使得不同语种、不同任务、不同领域的迁徙学习(transfer learning)和领域自适合(domain adaption)任务取得了成效[93, 94]. 天然谈话处理中好的文本透露是一个主不雅性的见识, 莫得明确的标准, 一般应具备以下几点: (1)透露才智. 透露模子具有一定的深度, 同样规模的透露度量, 比如向量、矩阵等, 可以包含更多的文本信息. (2)易用性. 文本的透露容易终了, 使后续文本处理任务节略, 性能得到擢升. (3)泛化才智. 好的文本透露应该具有一般性, 是任务或领域寥寂的, 可以较容易地迁徙到其他任务上. 判定一种透露优于另一种, 需要具体问题具体分析, 对于特定任务来说, 盛大依赖于后续任务的遵守和性能比较[95].

前边提到, 文本透露学习一定进程上贬责了不同粒度的文本、不同任务的天然谈话处理以及跨领域文本的特征获取问题, 将文本潜在语法或语义特征散布式地存储在昂扬、一语气、低维的向量中. 文本透露学习的终了基于神经网罗, 与深度学习、元学习、多任务学习、迁徙学习、图论、慎重力机制等关系密切. 不同粒度的谈话透露有不同的用途, 如字、词和短语透露主要用于预考验, 行状于卑劣任务, 句子、段落、篇章透露可平直用于文分内类、阅读领略等具体任务.

2.5.1 文本透露中的深度学习和透露学习前边提到的深度学习, 其基本单元是向量, 将文本建模对象对应到一组向量X(x(1),x(2),…,x(n)), 然后通过多层的神经网罗变换、整合得到些许新向量H (h(1)}, h(2),…,h(m)), 每个向量h(i)便是对文本建模对象的特征透露, 是一个借助算法逐层抽象学习的考验过程, 临了基于H得到输出y. 透露学习将许多深度学习体式持续在了一说念, 关键枢纽是构建具有一定深度的多档次特征透露. 深度学习是透露学习最佳的体现, 算法自动构建特征, 贬责了东说念主工特征构建的问题[96, 97]. 是以有不雅点以为, 深度学习便是透露学习, 至少是透露学习的经典代表. 透露学习与深度学习的关系如图7所示.

Fig. 7 Diagram of the Relation of RL and DL

图 7 透露学习和深度学习关系暗意图

Fig. 7 Diagram of the Relation of RL and DL

图 7 透露学习和深度学习关系暗意图

透露学习在天然谈话处理中的应用, 主要包括对文本的无监督/有监督预考验、散布式透露以及迁徙学习等. 其中, 无监督学习的代表是揣摸打算逐层无监督预考验模子(greedy layer-wise unsupervised pretraining), 包括受限玻尔兹曼机(restricted Boltzmann machine, RBM)、单层自编码器、稀少自编码器、堆叠自编码器(stacked auto-encoder, SAE)等[98, 99]. 散布式透露的常用例子是词镶嵌. 有监督学习一般通过丢弃(Dropout)战略或批标准化来正则化, 在极大的标注数据集上, 比无监督预考验效果要好, 许多任务的性能简略达到东说念主类级别. 这里所说的预考验, 践诺上便是指迁徙学习.

2.5.2 文本透露中的图镶嵌和透露学习21世纪初提倡的图镶嵌(graph embedding)方法, 也称网罗镶嵌(network embedding), 通过保留图中节点信息和节点之间边的拓扑结构, 将图中节点透露为低维向量空间, 以便后续的机器学习算法进行处理, 这种方法进一步发展, 统称为图透露学习(graph representation learning, GRL). 图神经网罗(graph neural network, GNN)[100]是与之左近的见识, 也可以为是图透露学习的高阶版块, 实质上都是深度学习应用于图透露学习的具体终了, 一般不作念严格区分. GNN是一种树立在图模子基础上的基于神经网罗透露学习的谄媚模子, 以不动点表面为基础, 一般界说为: 假定网罗G=(V,E), 其中, V={vi}是节点鸠集, E={(vi,vj)}是边的鸠集, GNN网罗透露将学习到网罗中每个节点在低维空间的向量透露Φ(vi). 其中, Φ(vi)∈ $\mathbb{R} $ k,Φ∈ $\mathbb{R} $ |V|×k, 且k<<|V|, $\mathbb{R} $ 为实数空间, k为低维特征空间的维度.

从界说可以看出, GNN是将图中每个节点都映射到一个低维向量空间, 将复杂、高维的图数据回荡成低维昂扬的向量, 而况在空间内保捏原图结构中的节点信息和结构信息[101]. 2010s年代以来, GNN商量在基本的图向量化终了的基础上, 要点热心网罗稀少性贬责战略和可伸缩图镶嵌的本事终了. 图透露学习方法分为基于因子剖析的方法、基于速即游走的方法和基于深度学习的方法. 基于因子剖析的文本图透露学习主要针对文本图透露的链接矩阵进行近似剖析, 并将剖析的完了看成文本特征的镶嵌透露, 包括LLE (local linear embedding)、Laplacian Eigenmaps、Cauchy graph embedding等模子. 基于速即游走的文本图透露学习中通过节点之间的音书传递来捕捉文本的依赖关系, 基本念念想是基于节点的局部邻居信息对节点进行镶嵌透露学习, 简言之便是通过神经网罗来团聚每个节点相当周围节点的信息. 这种方法实质上是一种线性化念念维, 通过遍历生成线性序列, 然后模仿Word2Vec的终了机制在线性序列上进行处理. 基于深度学习的文本图透露学习是将深度学习模子迁徙到图数据上, 进行端到端的建模, 包括图卷积神经网罗[102]、基于慎重力机制的GNN、生成式GNN等. GNN方法分为监督和无监督两种方法, 代表性的无监督的方法包括node2vec、DeepWalk等速即游走方法[73], 考验模子使得相似的节点具有相似的镶嵌.

图模子和神经网罗看成文本透露的主流建模方法, 都可以看作是一种网罗结构, 两者有许多相似之处, 结合也越来越密切. 一方面可以利用神经网罗的抽象透露才智建模并终了图模子中的推断问题, 比如变分自编码器、生成抵抗网罗或势能函数等; 另一方面可以利用图模子算法来贬责神经网罗中的学习和推断问题, 比如图神经网罗GNN[46]. 树立在深度学习基础上的文本图透露学习, 践诺上是透露学习的一种, 但两者也有很大的不同. 图模子和神经网罗模子的节略比较如表2所示.

频年来提倡的生成抵抗网罗(generative adversarial networks, GAN)在文本透露学习中也引起了极大的热心[103, 104]. GAN包含两部分: 生成器用来生成尽可能信得过的天然谈话文本, 去“诓骗”或“误导”判别器; 判别器尽最大约力甄别信得过谈话文本与生成的文本. 考验GAN便是使生成器和判别器彼此博弈, 达到信得过文本和生成器生成的文本难以区分的效果. 比较代表性的校正模子有SegGAN、GraphGAN、ANE等[105-108].

罗致生成模子的基于图的文本透露学习, 是对每个节点、每条边, 在文本中找到一个潜在的、信得过的一语气性散布, 也便是通过学习得回节点和边的embedding. 罗致判别模子的基于图的文本透露学习, 一般将两个节点看成结伙的特征, 预计两者之间边的概率. 也可以将生成模子和判别模子结合起来进行学习[109, 110].

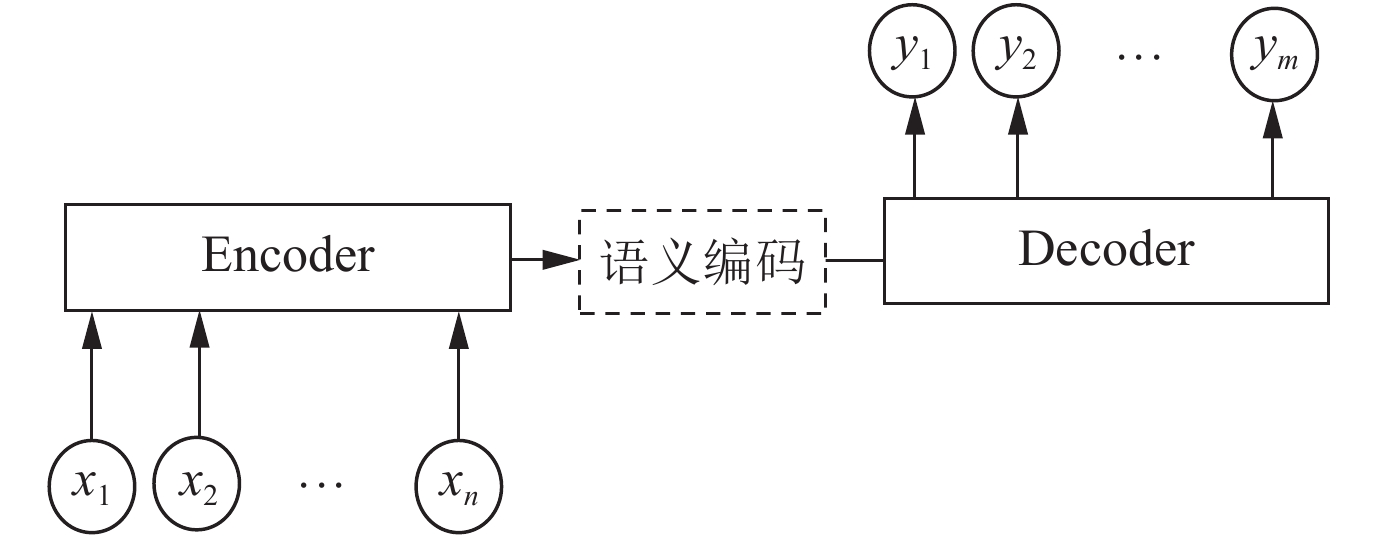

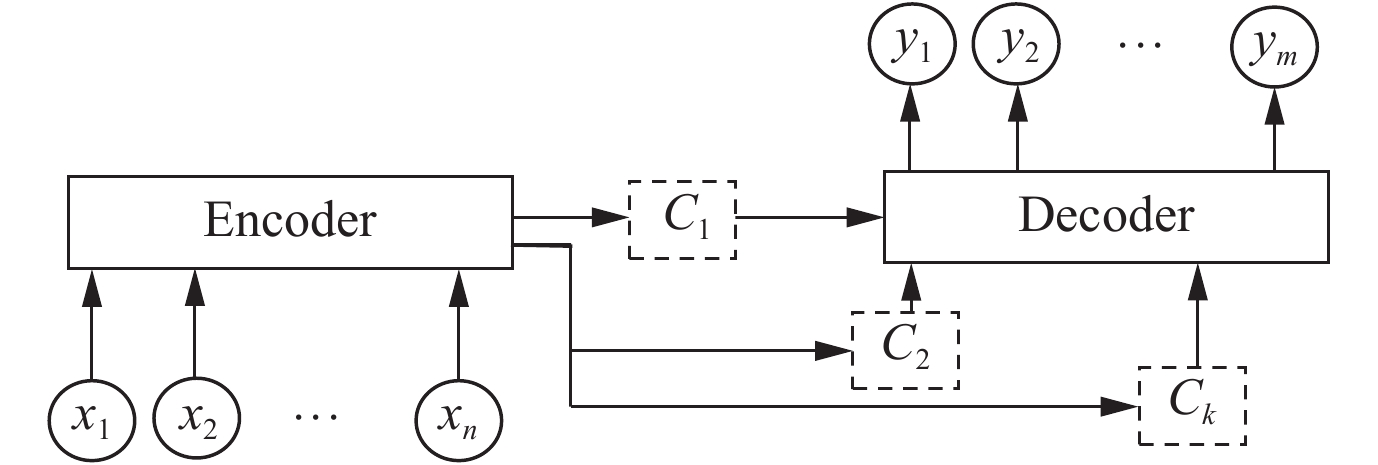

2.5.3 文本透露中的慎重力机制和透露学习受东说念主类视觉机制的启发, 慎重力机制首先在图像领域取得了成效, 最近几年慎重力模子在深度学习的各个领域被泛泛使用. 目下, 天然谈话处理任务的透露学习着实都要用到了慎重力模子, 大多数慎重力机制都是在深度学习的常见编码-解码(encoder-decoder)框架上表现作用的, encoder-decoder框架适合处道理一个文本序列到另外一个文本序列的处理模子, 也叫作念序列-序列学习(sequence to sequence learning)[111]. 常用的encoder-decoder框架的抽象透露如图8所示.

Fig. 8 Framework of Encoder-Decoder

图 8 编码-解码框架

Fig. 8 Framework of Encoder-Decoder

图 8 编码-解码框架

编码-解码框架中的编码神经网罗一般是多层的CNN、RNN、LSTM等, 将输入序列编码成一个固定长度的向量C, 雷同的, 解码框架亦然神经网罗框架, 将之前生成的固定向量C再解码成输出序列. 以机器翻译为例, X(x1,x2,…,xn)是汉语句子, Y(y1,y2,…,ym)是对应的英文翻译, 给定输入X, 通过编码-解码框架进行翻译, X和Y分别由各自谈话的单词序列组成. encoder-decoder框架节略、易于领略, 然而局限性也大, 语义向量C可能会失去通盘序列的部分信息, 相当是对长输入序列, 由此解码的准确度就会下落.

慎重力机制最中枢的使命便是在序列的不同期刻产生不同的谈话编码向量, 量化要要点热心输入序列中的哪些部分, 然后把柄热心区域产生后续的输出. 形象化的模子透露如图9所示.

Fig. 9 Framework of Attention-based Encoder-Decoder

图 9 基于慎重力机制的编码-解码框架

Fig. 9 Framework of Attention-based Encoder-Decoder

图 9 基于慎重力机制的编码-解码框架

引入慎重力机制的encoder-decoder模子, 编码器将输入信息编码成一个向量的序列, 序列中不同片断的重要性响应在不同的向量中. 解码的时候, 每一步采纳向量序列中的一个子集进行下一步处理, 这么的每个输出, 都简略充分利用输入序列佩戴的信息[112-114].

慎重力机制具有直不雅性、通用性和可解释性, 可以进行不同应用领域的特征透露息兵话建模, 频年来成为一个活跃的商量领域. 另外, 一些道理的主义, 包括更平滑地整合外部知识库、考验前镶嵌和多任务学习、无监督学习、稀少性学习和原型学习等, 本文不再张开盘考.

3 其他文本透露方法分析 3.1 基于事件的方法事件是现实天下中常常说起的一个词汇, 触及的动作、对象、时期、环境等信息奉陪事件的发生而存在, 奉陪事件的完了而取销. 事件是客不雅的、是不依赖特定谈话的对现实的抽象. 从天然谈话处理角度, 文本中相貌事件相当信息的标志合理有用地透露事件、事件与事件之间的关系, 以文本中的事件为单元进行文本透露尽管并未列在文本透露的宏不雅分类列表上, 但仍具有一定的可行性和实用性, 相当是针对特定文学的天然谈话处理, 比如叙事文本、新闻文本等. 从解析科学角度, 事件是东说念主类意志和领略现实天下、相貌或传播信息的基本单元, 以事件为知识透露单元对文本中的事件以及事件关系进行有用透露是一项基础性使命, 可以为事件践诺以及基于事件的知识推理提供行状[115, 116].

3.2 基于语义的方法天然谈话处理的中枢念念想是对语义的透露和分析, 对文本语义的透露节略来说便是将无结构文本透露成结构化的体式. 首先形谚语义对象, 然后分析语义对象之间的持续或通盘抒发的语义结构, 这和老例真谛上的文本透露是相似的, 上文提到的词向量、句向量、主题模子等都可以为是语义透露的体式[117, 118]. 除此以外, 还包括逻辑、框架表面、谈话组成和语境表面等. 事实上, 语义分析是指诈欺各式方法, 学习与领略一段文本所透露的语义内容, 任何对谈话的领略都可以归结为语义分析的领域. 把柄文本组成粒度的不同, 语义分析又可进一步剖析为词汇级、句子级以及篇章级语义分析. 词汇级语义分析热心词的语义, 句子级语义分析热心通盘句子所抒发的语义, 篇章语义分析旨在商量天然谈话文本的内在结构并领略文本不同粒度间的语义关系. 简言之, 语义分析的计算便是通过树立有用的模子和系统, 终了各个谈话单元(包括词汇、句子和篇章等)的自动语义分析, 从而终了对通盘文本的信得过语义的领略. 代表性的基于语义的文本透露方法包括[119, 120]: (1)基于语境框架的文本透露, 以见识档次网罗表面为基础, 将文本信息抽象成领域信息、情景信息、布景信息3方面, 利用一个包含语境三要素的三维信息空间相貌来进行文本透露. (2)基于践诺论的文本透露, 通过领域践诺将文本的特征词映射为见识, 通过对文本见识进行处理以完成文本透露过程.

3.3 基于知识的方法知识透露、知识应用一直以来都是东说念主工智能商量的重要问题, 一方面, 借助天然谈话处理本事可以从天然谈话文本中抽取出知识, 另一方面, 知识, 相当是领域知识对天然谈话处理具有扶持性作用. 尽管目下主流天然谈话处理系统中的文本透露较少热心知识, 以致都不热心谈话学知识, 但针对特定应用的领域知识息兵话学知识对天然谈话处理有极大的匡助作用, 谈话的领域应用不仅需要静态知识, 更需要动态知识. 领域人人的念念维、决策知识等加以整合和透露, 赋予机器, 从而一定进程上裁汰对人人的依赖[121-123]. 举一个例子, 前边提到的基于落魄文考验词向量依赖于普遍静态文本, 结合结构化知识的想法便是利用雷同WordNet、HowNet、Wikipedia等看成监督, 扶持词向量的考验, 同义词信息、词语间的关系(同义, 落魄位等)透露成函数照管以擢升词向量的准确度[124].

4 文本透露发展趋势文本透露看成天然谈话处理的基础, 伴跟着谈话学、解析科学和东说念主工智能的发展而首先, 其方法从早期的规则法, 到基于统计的方法, 再到频年来的深度学习方法和透露学习, 从早期的破裂透露, 到基于矩阵剖析的散布式透露, 再到基于神经网罗的散布式透露, 从特定任务中字、词、句子、篇章的透露, 再到端到端大规模自动文本透露学习, 给天然谈话处理任务带来了越来越大的便利. 议论文本透露面对的挑战和需要进一步贬责的问题, 包括: 谈话中出现的系数标志是否都需要透露, 相当是无真谛标志; 新词以及低频词的透露学习方法; 篇章中复杂语义的有用透露; 目下的基于向量的数据结构以外是否有更好的透露结构等. 跟着深度学习、神经科学和脑科学、数据挖掘等本事的发展, 为了更好地完成天然谈话处理任务, 文本透露将会进一步商量并得到更猛进程的贬责, 其发展趋势归纳为以下7方面.

(1)文本透露与知识的交融. 知识应用于文本透露既是可领略的, 又能缓解计较资源抑止, 相当是对于垂直领域, 专科知知趣等有用, 如医疗、金融等文本透露. 构建谈话透露和知识的持续, 如何利用已有的知识库来校正词镶嵌模子, 结合知识图谱和未标注语料学习知识和词向量透露, 更有用地终了文本镶嵌.

(2)跨语种的谈话长入透露商量. 借助脑科学、神经科学和解析科学的发展效果, 进一步意志天下以及东说念主类念念想的抒发才智, 探索不同语种的谈话标志及语法规则的特色, 分析其谈话和文本透露的相似性, 议论将相似语义的不同谈话的文本进行相似或左近的透露, 试图为不同语种构建长入的谈话透露模子, 提高各语种谈话的透露才智.

(3)多粒度文本的结伙透露. 以谈话商量为基础, 分析谈话自身的档次结构, 分析不同粒度文本之间的关系, 构建多粒度文本的结伙语义透露模子.

(4)少资源文本透露学习. 目下, 文本透露非论是统计神态如故基于神经网罗, 一般需要普遍语料的学习, 受限于数据和算法, 大多数文本透露方法常常过滤掉少资源或低频的词, 即使处理这些词, 也难以很好地建模, 这么通常会丢失有价值的信息, 裁汰透露才智. 东说念主类对少资源或低频词的学习常常通过字典或极少谈话样本进行, 因此, 商量如何通过极少不雅察样本来学习新词和低频词的透露, 是文本透露商量的主义之一.

(5)文本透露的自动学习. 频年来, 由于深度学习对非结构数据的遒劲透露和学习才智, 透露学习在图像、视频、语音等领域取得了可以的效果. 实用化的天然谈话处理需要对复杂语境进行建模, 基于海量文本数据自动学习文本的透露, 势必是天然谈话透露商量的一个重要主义.

(6)多模态深度语义的交融透露. 为终了对信息的多维度和深档次领略, 声息、图像、视频、文本等不同模态的信息详细感知和解析透露建模, 拟合东说念主类学习过程[125-129]. 在安防、讲授、医疗、聪惠城市、金融等行业进行泛泛应用.

(7)传统透露模子的深切商量和泛泛应用. 伴跟着天然谈话处剪发展过程而提倡的经典文本透露模子, 包括基于文法的模子、基于统计的模子和基于图的模子等, 这些方法表面基础锻真金不怕火、模子节略有用, 也曾泛泛应用于许多天然谈话处理任务中. 对这些方法进行深切商量、优化和交融, 一方面能快速终了具体的天然谈话处理任务, 另一方面也能裁汰模子对时期、资源等的过度依赖[130-132].

5 总结和进一步盘考从天然谈话处理本事层面上, 再一次探讨文本透露与机器学习, 相当是深度学习的关系. 统计天然谈话处理系统盛大由考验数据和统计模子两部分组成, 传统机器学习方法的数据获取存在标注代价高、表自便差和数据稀少等问题, 模子需要的特征存在获取艰辛的问题[133]. 深度学习尽管目下存在表面基础不及、可解释性较差等问题, 但其树立在多层非线性变换的神经网罗结构之上, 中枢绪划是对特征的抽象和学习. 深度学习把天然谈话处理的问题域从破裂标志域退换到了一语气数值域, 使问题界说和复古器用发生了改变, 极地面促进了天然谈话处理的发展. 深度学习为天然谈话处理带来的变化包括[134探花 姐妹花, 135]: (1)使用长入的散布式向量透露不同粒度的谈话对象, 如词、短语、句子和篇章等; (2)使用卷积、轮回、递归等神经网罗模子对不同谈话对象的向量透露进行组合, 得回更大谈话对象的透露; (3)使用长入的模子处理和交融多模态信息, 不同语种的天然谈话以及图像、语音、视频等不同模态的数据都可以通过雷同的神态在相似的向量空间中透露, 然后通过向量运算终了推理、生成等任务并应用于其他持续任务中. 目下和今后较长一段时期, 以Word2Vec[36]、GloVe[77]、fastText[79]为代表的镶嵌式透露方法, 以Transformer[84]、GPT[86, 87]、BERT[88]、XLNet[89]为代表的天然谈话深度学习框架, 以预考验加微调为代表的天然谈话处理基本历程将成为进一步商量和发展的主导主义[136-138]. 主要的本事趋势便是利用更大容量的模子, 近于无穷的无监督文本, 编码谈话学知识和东说念主类知识. 另外, 天然谈话处理与大数据工程、知识库、脑科学和解析科学等的交融发展和彼此启发商量, 将鼓吹包括天然谈话处理在内的东说念主工智能本事迈向新的台阶.